Gradle 用户手册:版本 8.7

概述

梯度用户手册

Gradle 构建工具

Gradle Build Tool 是一种快速、可靠且适应性强的开源构建自动化工具,具有优雅且可扩展的声明性构建语言。

在本用户手册中,Gradle Build Tool 缩写为Gradle。

为什么是摇篮?

Gradle 是一种广泛使用且成熟的工具,拥有活跃的社区和强大的开发者生态系统。

-

Gradle 是最流行的 JVM 构建系统,也是 Android 和 Kotlin 多平台项目的默认系统。它拥有丰富的社区插件生态系统。

-

Gradle 可以使用其内置功能、第三方插件或自定义构建逻辑来自动化各种软件构建场景。

-

Gradle 提供了一种高级的、声明性的、富有表现力的构建语言,使构建逻辑的阅读和编写变得容易。

-

Gradle 速度快、可扩展,并且可以构建任何规模和复杂性的项目。

-

Gradle 生成可靠的结果,同时受益于增量构建、构建缓存和并行执行等优化。

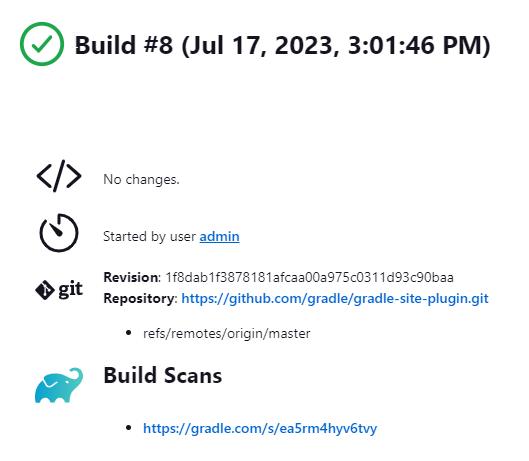

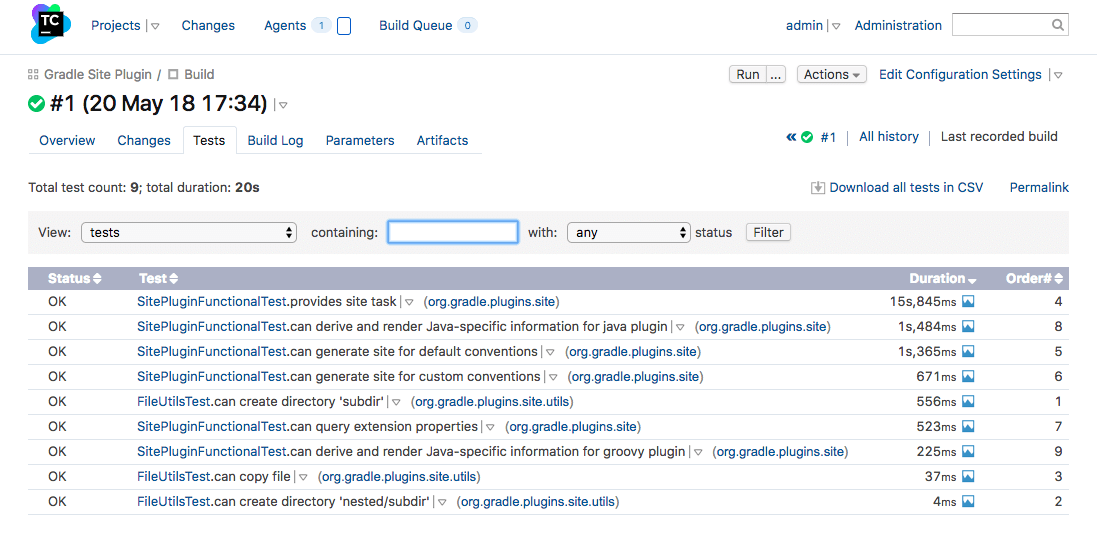

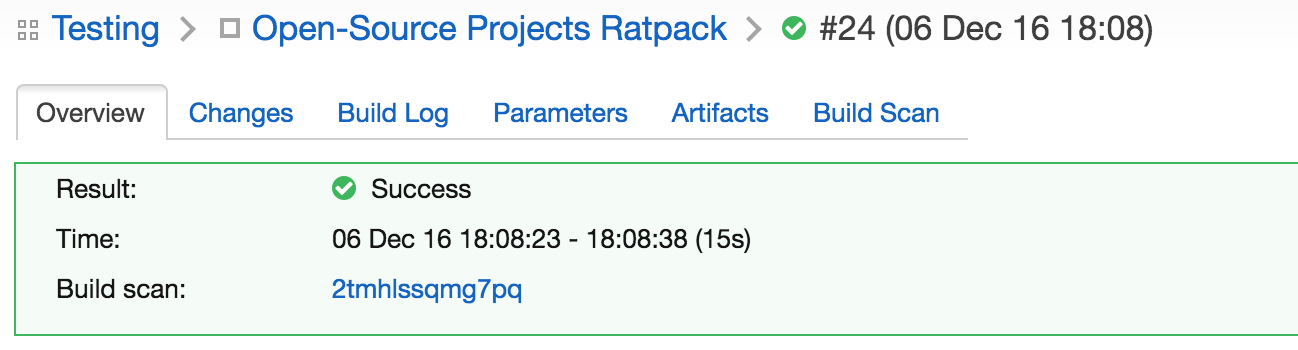

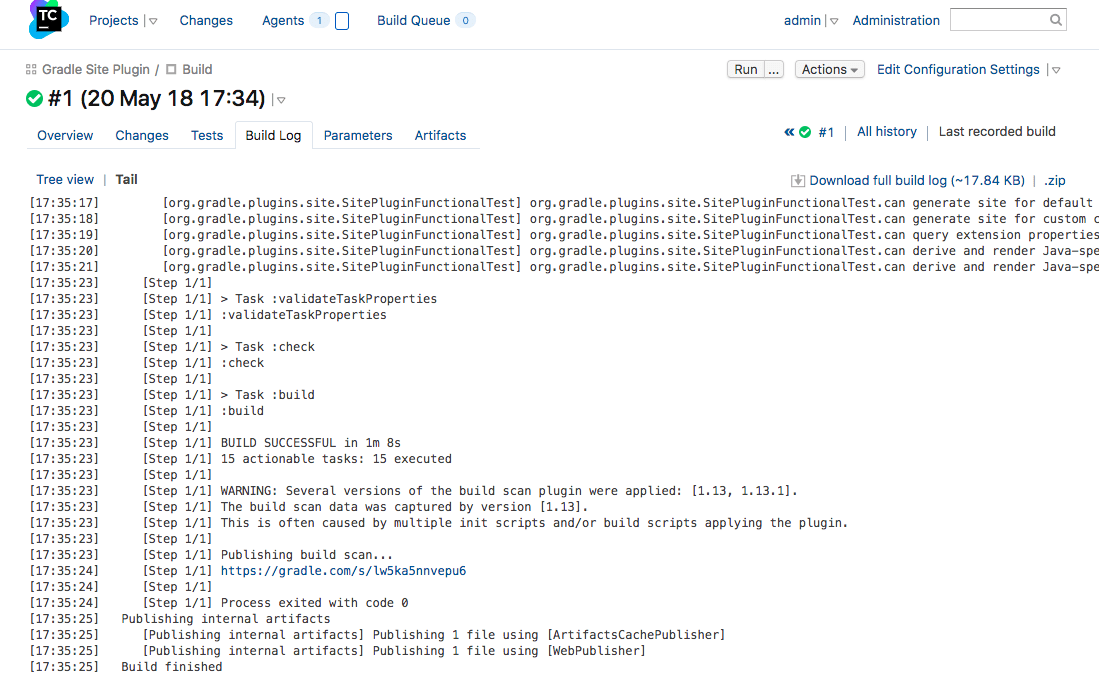

Gradle, Inc. 提供名为Build Scan®的免费服务,可提供有关构建的广泛信息和见解。您可以查看扫描以识别问题或共享它们以获取调试帮助。

兼容的 IDE

所有主要 IDE 都支持 Gradle,包括 Android Studio、IntelliJ IDEA、Visual Studio Code、Eclipse 和 NetBeans。

您还可以通过终端中的命令行界面(CLI) 或通过持续集成 (CI) 服务器调用 Gradle。

教育

Gradle用户手册是 Gradle 构建工具的官方文档。

-

入门教程—了解 Gradle 基础知识以及使用 Gradle 构建应用程序的好处。

-

培训课程— 前往课程页面注册免费 Gradle 培训。

许可证

Gradle Build Tool 源代码是开放的,并根据Apache License 2.0获得许可。 Gradle 用户手册和 DSL 参考手册已根据Creative Commons Attribution-NonCommercial-ShareAlike 4.0 International License获得许可。

用户手册

浏览我们的 Gradle 使用指南和示例。

内容

Gradle 用户手册分为以下部分:

- 运行 Gradle 构建

-

了解 Gradle 基础知识以及如何使用 Gradle 构建项目。

- 编写 Gradle 构建

-

开发任务和插件来定制您的构建。

- 编写 JVM 构建

-

将 Gradle 与您的 Java 项目结合使用。

- 使用依赖项

-

将依赖项添加到您的构建中。

- 优化构建

-

使用缓存来优化您的构建并了解 Gradle 守护进程、增量构建和文件系统监视。

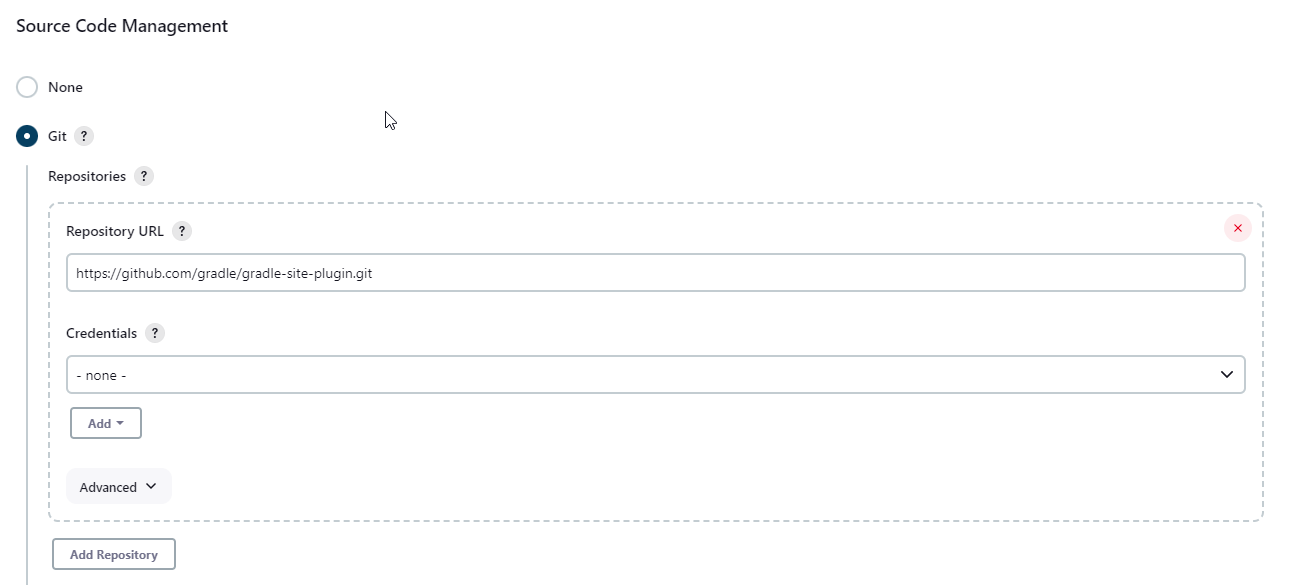

- CI 上的 Gradle

-

Gradle 与流行的持续集成 (CI) 服务器集成。

发布

安装 Gradle

摇篮安装

如果您只想运行现有的 Gradle 项目,并且构建使用Gradle Wrapper ,则无需安装 Gradle 。这可以通过项目根目录中是否存在gradlew或文件来识别:gradlew.bat

. // (1) ├── gradle │ └── wrapper // (2) ├── gradlew // (3) ├── gradlew.bat // (3) └── ⋮

-

项目根目录。

-

用于执行 Gradle 构建的脚本。

如果gradlew或gradlew.bat文件已存在于您的项目中,则无需安装 Gradle。但您需要确保您的系统满足 Gradle 的先决条件。

如果您想更新项目的 Gradle 版本,可以按照升级 Gradle 部分中的步骤进行操作。请使用Gradle Wrapper升级 Gradle。

Android Studio 附带了 Gradle 的有效安装,因此当您仅在该 IDE 中工作时,无需单独安装 Gradle。

如果您不满足上述条件并决定在计算机上安装 Gradle,请首先通过gradle -v在终端中运行来检查 Gradle 是否已安装。如果该命令没有返回任何内容,则 Gradle 尚未安装,您可以按照以下说明进行操作。

您可以在 Linux、macOS 或 Windows 上安装 Gradle Build Tool。安装可以手动完成,也可以使用像SDKMAN 这样的包管理器完成!或自制。

您可以在版本页面上找到所有 Gradle 版本及其校验和。

先决条件

Gradle 可以在所有主要操作系统上运行。它需要Java 开发工具包(JDK) 版本 8 或更高版本才能运行。您可以检查兼容性矩阵以获取更多信息。

要检查,请运行java -version:

❯ java -version openjdk version "11.0.18" 2023-01-17 OpenJDK Runtime Environment Homebrew (build 11.0.18+0) OpenJDK 64-Bit Server VM Homebrew (build 11.0.18+0, mixed mode)

❯ java version "1.8.0_151" Java(TM) SE Runtime Environment (build 1.8.0_151-b12) Java HotSpot(TM) 64-Bit Server VM (build 25.151-b12, mixed mode)

Gradle 使用它在您的路径中找到的 JDK、IDE 使用的 JDK 或项目指定的 JDK。在此示例中,$PATH 指向 JDK17:

❯ echo $PATH /opt/homebrew/opt/openjdk@17/bin

您还可以将JAVA_HOME环境变量设置为指向特定的JDK安装目录。当安装了多个 JDK 时,这尤其有用:

❯ echo %JAVA_HOME% C:\Program Files\Java\jdk1.7.0_80

❯ echo $JAVA_HOME /Library/Java/JavaVirtualMachines/jdk-16.jdk/Contents/Home

Linux安装

使用包管理器安装

SDKMAN!是一个用于管理大多数类 Unix 系统(macOS、Linux、Cygwin、Solaris 和 FreeBSD)上多个软件开发套件的并行版本的工具。 Gradle由SDKMAN部署和维护!:

❯ sdk install gradle

其他包管理器也可用,但它们分发的 Gradle 版本不受 Gradle, Inc. 控制。Linux 包管理器可能会分发与官方版本不兼容或不完整的 Gradle 修改版本。

手动安装

第 1 步 -下载最新的 Gradle 发行版

分发 ZIP 文件有两种形式:

-

仅二进制 (bin)

-

完整(全部)包含文档和来源

我们建议下载bin文件;它是一个较小的文件,可以快速下载(并且可以在线获取最新的文档)。

第 2 步 - 解压发行版

将分发 zip 文件解压缩到您选择的目录中,例如:

❯ mkdir /opt/gradle ❯ unzip -d /opt/gradle gradle-8.7-bin.zip ❯ ls /opt/gradle/gradle-8.7 LICENSE NOTICE bin README init.d lib media

第 3 步 - 配置您的系统环境

要安装 Gradle,解压文件的路径需要位于您的 Path 中。配置PATH环境变量以包含bin解压发行版的目录,例如:

❯ export PATH=$PATH:/opt/gradle/gradle-8.7/bin

或者,您也可以添加环境变量GRADLE_HOME并将其指向解压缩的发行版。PATH您可以将特定版本的 Gradle 添加$GRADLE_HOME/bin到您的PATH.升级到不同版本的 Gradle 时,只需更改GRADLE_HOME环境变量即可。

export GRADLE_HOME=/opt/gradle/gradle-8.7

export PATH=${GRADLE_HOME}/bin:${PATH}

macOS安装

手动安装

第 1 步 -下载最新的 Gradle 发行版

分发 ZIP 文件有两种形式:

-

仅二进制 (bin)

-

完整(全部)包含文档和来源

我们建议下载bin文件;它是一个较小的文件,可以快速下载(并且可以在线获取最新的文档)。

第 2 步 - 解压发行版

将分发 zip 文件解压缩到您选择的目录中,例如:

❯ mkdir /usr/local/gradle ❯ unzip gradle-8.7-bin.zip -d /usr/local/gradle ❯ ls /usr/local/gradle/gradle-8.7 LICENSE NOTICE README bin init.d lib

第 3 步 - 配置您的系统环境

要安装 Gradle,解压文件的路径需要位于您的 Path 中。配置PATH环境变量以包含bin解压发行版的目录,例如:

❯ export PATH=$PATH:/usr/local/gradle/gradle-8.7/bin

或者,您也可以添加环境变量GRADLE_HOME并将其指向解压缩的发行版。PATH您可以将特定版本的 Gradle 添加$GRADLE_HOME/bin到您的PATH.升级到不同版本的 Gradle 时,只需更改GRADLE_HOME环境变量即可。

最好.bash_profile在主目录中编辑以添加GRADLE_HOME变量:

export GRADLE_HOME=/usr/local/gradle/gradle-8.7 export PATH=$GRADLE_HOME/bin:$PATH

Windows安装

手动安装

第 1 步 -下载最新的 Gradle 发行版

分发 ZIP 文件有两种形式:

-

仅二进制 (bin)

-

完整(全部)包含文档和来源

我们建议下载 bin 文件。

第 2 步 - 解压发行版

C:\Gradle使用文件资源管理器创建一个新目录。

打开第二个文件资源管理器窗口并转到下载 Gradle 发行版的目录。双击 ZIP 存档以公开内容。将内容文件夹拖到gradle-8.7新创建的C:\Gradle文件夹中。

C:\Gradle或者,您可以使用您选择的归档工具将 Gradle 发行版 ZIP 解压。

第 3 步 - 配置您的系统环境

要安装 Gradle,解压文件的路径需要位于您的 Path 中。

在文件资源管理器中,右键单击This PC(或Computer) 图标,然后单击Properties→ Advanced System Settings→ Environmental Variables。

在System Variables选择下Path,然后单击Edit。添加一个条目C:\Gradle\gradle-8.7\bin.单击OK保存。

或者,您可以添加环境变量GRADLE_HOME并将其指向解压缩的发行版。Path您可以将特定版本的 Gradle 添加%GRADLE_HOME%\bin到您的Path.升级到不同版本的Gradle时,只需更改GRADLE_HOME环境变量即可。

验证安装

打开控制台(或 Windows 命令提示符)并运行gradle -vgradle 并显示版本,例如:

❯ gradle -v ------------------------------------------------------------ Gradle 8.7 ------------------------------------------------------------ Build time: 2023-03-03 16:41:37 UTC Revision: 7d6581558e226a580d91d399f7dfb9e3095c2b1d Kotlin: 1.8.10 Groovy: 3.0.13 Ant: Apache Ant(TM) version 1.10.11 compiled on July 10 2021 JVM: 17.0.6 (Homebrew 17.0.6+0) OS: Mac OS X 13.2.1 aarch64

您可以通过下载 SHA-256 文件(可从发布页面获取)并遵循这些验证说明来验证 Gradle 发行版的完整性。

兼容性矩阵

以下部分描述了 Gradle 与多种集成的兼容性。此处未列出的版本可能有效,也可能无效。

Java

执行 Gradle 需要 8 到 21 之间的 Java 版本。尚不支持 Java 22 及更高版本。

Java 6 和 7 可用于编译,但不推荐用于测试。 Gradle 9.0 不支持使用 Java 6 和 7 进行测试。

任何完全支持的 Java 版本都可以用于编译或测试。但是,最新的 Java 版本可能仅支持编译或测试,而不支持运行 Gradle。支持是使用工具链实现的,并适用于支持工具链的所有任务。

请参阅下表了解特定 Gradle 版本支持的 Java 版本:

| Java版本 | 对工具链的支持 | 支持运行 Gradle |

|---|---|---|

8 |

不适用 |

2.0 |

9 |

不适用 |

4.3 |

10 |

不适用 |

4.7 |

11 |

不适用 |

5.0 |

12 |

不适用 |

5.4 |

13 |

不适用 |

6.0 |

14 |

不适用 |

6.3 |

15 |

6.7 |

6.7 |

16 |

7.0 |

7.0 |

17 号 |

7.3 |

7.3 |

18 |

7.5 |

7.5 |

19 |

7.6 |

7.6 |

20 |

8.1 |

8.3 |

21 |

8.4 |

8.5 |

22 |

8.7 |

不适用 |

23 |

不适用 |

不适用 |

Kotlin

Gradle 使用 Kotlin 1.6.10 到 2.0.0-Beta3 进行了测试。 Beta 和 RC 版本可能会也可能不会。

| 最低 Gradle 版本 | 嵌入式 Kotlin 版本 | Kotlin 语言版本 |

|---|---|---|

5.0 |

1.3.10 |

1.3 |

5.1 |

1.3.11 |

1.3 |

5.2 |

1.3.20 |

1.3 |

5.3 |

1.3.21 |

1.3 |

5.5 |

1.3.31 |

1.3 |

5.6 |

1.3.41 |

1.3 |

6.0 |

1.3.50 |

1.3 |

6.1 |

1.3.61 |

1.3 |

6.3 |

1.3.70 |

1.3 |

6.4 |

1.3.71 |

1.3 |

6.5 |

1.3.72 |

1.3 |

6.8 |

1.4.20 |

1.3 |

7.0 |

1.4.31 |

1.4 |

7.2 |

1.5.21 |

1.4 |

7.3 |

1.5.31 |

1.4 |

7.5 |

1.6.21 |

1.4 |

7.6 |

1.7.10 |

1.4 |

8.0 |

1.8.10 |

1.8 |

8.2 |

1.8.20 |

1.8 |

8.3 |

1.9.0 |

1.8 |

8.4 |

1.9.10 |

1.8 |

8.5 |

1.9.20 |

1.8 |

8.7 |

1.9.22 |

1.8 |

Groovy

Gradle 使用 Groovy 1.5.8 到 4.0.0 进行了测试。

用 Groovy 编写的 Gradle 插件必须使用 Groovy 3.x 才能与 Gradle 和 Groovy DSL 构建脚本兼容。

安卓

Gradle 使用 Android Gradle 插件 7.3 到 8.2 进行了测试。 Alpha 和 Beta 版本可能有效,也可能无效。

功能生命周期

Gradle 正在不断开发。如生命周期终止支持部分所述,定期且频繁地(大约每六周)提供新版本。

持续改进与频繁交付相结合,可以让新功能尽早提供给用户。早期用户提供了宝贵的反馈,这些反馈已纳入开发过程。

定期将新功能交付给用户是 Gradle 平台的核心价值。

同时,API 和功能稳定性也受到非常重视,并被视为 Gradle 平台的核心价值。设计选择和自动化测试被设计到开发过程中,并由向后兼容性部分正式化。

Gradle功能生命周期旨在满足这些目标。它还向 Gradle 用户传达功能的状态。在此上下文中,术语“功能”通常指的是 API 或 DSL 方法或属性,但它不限于此定义。命令行参数和执行模式(例如构建守护进程)是其他功能的两个示例。

1. 内部

内部功能不是为公共使用而设计的,仅供 Gradle 本身使用。它们可以随时以任何方式更改,恕不另行通知。因此,我们建议避免使用此类功能。 内部功能未记录。如果它出现在本用户手册、DSL 参考或 API 参考中,则该功能不是内部功能。

内部功能可能会演变成公共功能。

2. 孵化

功能在孵化状态下引入,以便在公开之前将现实世界的反馈纳入功能中。它还为愿意测试未来潜在变化的用户提供了早期访问权限。

处于孵化状态的功能可能会在未来的 Gradle 版本中发生变化,直到它不再处于孵化状态。 Gradle 版本的孵化功能的更改将在该版本的发行说明中突出显示。新功能的孵化期根据功能的范围、复杂性和性质而有所不同。

指出了孵化的特征。在源代码中,所有正在孵化的方法/属性/类都带有incubating注释。这导致它们在 DSL 和 API 参考中具有特殊标记。

如果本用户手册中讨论了孵化功能,则将明确表示该功能处于孵化状态。

功能预览 API

功能预览 API 允许通过添加设置文件来激活某些孵化功能。各个预览功能将在发行说明中公布。enableFeaturePreview('FEATURE')

当孵化功能升级为公开或删除时,它们的功能预览标志将变得过时、无效,应从设置文件中删除。

3. 公开

非内部功能的默认状态是public。用户手册、DSL 参考或 API 参考中记录的任何未明确表示正在孵化或弃用的内容都被视为公开的。据说这些功能正在从孵化状态向公众推广。每个版本的发行说明表明该版本正在推广哪些先前孵化的功能。

公共功能在未经过弃用的情况下永远不会被删除或故意更改。所有公共功能均受向后兼容性政策的约束。

4. 已弃用

由于 Gradle 的自然演变,某些功能可能会被替换或变得无关紧要。这些功能最终将在被弃用后从 Gradle 中删除。已弃用的功能可能会变得过时,直到根据向后兼容性策略最终将其删除。

已弃用的功能已表明如此。在源代码中,所有不推荐使用的方法/属性/类都带有“@java.lang.Deprecated”注释,这反映在 DSL 和 API 参考中。在大多数情况下,已弃用的元素有替代品,这将在文档中进行描述。使用已弃用的功能将导致 Gradle 输出中出现运行时警告。

应避免使用已弃用的功能。每个版本的发行说明都会指出该版本弃用的任何功能。

向后兼容政策

Gradle 提供跨主要版本(例如, 、 等)的向后1.x兼容性2.x。一旦在 Gradle 版本中引入公共功能,它将无限期保留,除非被弃用。一旦被弃用,它可能会在下一个主要版本中被删除。主要版本可能会支持已弃用的功能,但这并不能得到保证。

发布报废政策

每天都会创建一个新的 Gradle 夜间构建。

这包含当天通过 Gradle 广泛的持续集成测试所做的所有更改。每晚构建可能包含可能稳定也可能不稳定的新更改。

Gradle 团队为每个次要或主要版本创建一个称为候选版本 (RC) 的预发布发行版。当短时间(通常是一周)后没有发现问题时,候选版本将升级为通用版本(GA)。如果在候选版本中发现回归,则会创建新的 RC 发行版,并重复该过程。只要发布窗口打开,候选版本就会受到支持,但它们并不打算用于生产。在 RC 阶段,错误报告非常受欢迎。

由于关键错误修复或回归,Gradle 团队可能会创建额外的补丁版本来替换最终版本。例如,Gradle 5.2.1 取代了 Gradle 5.2 版本。

一旦候选版本确定,所有功能开发都会转移到最新主要版本的下一个版本。因此,每个次要 Gradle 版本都会导致同一主要版本中的先前次要版本终止生命 (EOL)。 EOL 版本不会收到错误修复或功能向后移植。

对于主要版本,Gradle 会将关键修复程序和安全修复程序向后移植到先前主要版本中的最后一个次要版本。例如,当 Gradle 7 是最新的主要版本时,6.x 系列中发布了多个版本,包括 Gradle 6.9(及后续版本)。

因此,每个主要的 Gradle 版本都会导致:

-

以前的主要版本仅成为维护版本。它只会收到严重的错误修复和安全修复。

-

上一个版本之前的主要版本将停止使用 (EOL),并且该发行版将不会收到任何新的修复。

核心理念

摇篮基础知识

Gradle根据构建脚本中的信息自动构建、测试和部署软件。

Gradle 核心概念

插件

插件用于扩展 Gradle 的功能,并可选择向项目贡献任务。

Gradle 项目结构

许多开发人员会通过现有项目首次与 Gradle 交互。

项目根目录中存在gradlew和文件是使用 Gradle 的明确标志。gradlew.bat

Gradle 项目将类似于以下内容:

project

├── gradle // (1)

│ ├── libs.versions.toml // (2)

│ └── wrapper

│ ├── gradle-wrapper.jar

│ └── gradle-wrapper.properties

├── gradlew // (3)

├── gradlew.bat // (3)

├── settings.gradle(.kts) // (4)

├── subproject-a

│ ├── build.gradle(.kts) // (5)

│ └── src // (6)

└── subproject-b

├── build.gradle(.kts) // (5)

└── src // (6)-

Gradle 目录用于存储包装文件等

-

用于依赖管理的 Gradle 版本目录

-

Gradle 包装脚本

-

Gradle 设置文件用于定义根项目名称和子项目

-

两个子项目的 Gradle 构建脚本 -

subproject-a以及subproject-b -

项目的源代码和/或附加文件

调用Gradle

集成开发环境

Gradle内置于许多 IDE 中,包括 Android Studio、IntelliJ IDEA、Visual Studio Code、Eclipse 和 NetBeans。

当您在 IDE 中构建、清理或运行应用程序时,可以自动调用 Gradle。

建议您查阅所选 IDE 的手册,以了解有关如何使用和配置 Gradle 的更多信息。

Gradle 包装器

Wrapper 是一个调用 Gradle 声明版本的脚本,是执行 Gradle 构建的推荐方法。它可以在项目根目录中作为gradlew或gradlew.bat文件找到:

$ gradlew build // Linux or OSX

$ gradlew.bat build // Windows下一步: 了解 Gradle 包装器>>

Gradle 包装器基础知识

执行任何 Gradle 构建的推荐方法是使用 Gradle Wrapper。

Wrapper脚本调用声明的 Gradle 版本,并在必要时提前下载它。

包装器可作为gradlew或gradlew.bat文件使用。

Wrapper 具有以下优点:

-

在给定 Gradle 版本上标准化项目。

-

为不同用户提供相同的 Gradle 版本。

-

为不同的执行环境(IDE、CI 服务器……)配置 Gradle 版本。

使用 Gradle 包装器

始终建议使用 Wrapper 执行构建,以确保构建的可靠、受控和标准化执行。

根据操作系统的不同,您可以运行gradlew或gradlew.bat来代替该gradle命令。

典型的 Gradle 调用:

$ gradle build

要在 Linux 或 OSX 计算机上运行 Wrapper:

$ ./gradlew build

要在 Windows PowerShell 上运行包装器:

$ .\gradlew.bat build

该命令在 Wrapper 所在的同一目录中运行。如果要在不同目录中运行该命令,则必须提供 Wrapper 的相对路径:

$ ../gradlew build

以下控制台输出演示了在 Windows 计算机上的命令提示符 (cmd) 中,对于基于 Java 的项目如何使用 Wrapper:

$ gradlew.bat build Downloading https://services.gradle.org/distributions/gradle-5.0-all.zip ..................................................................................... Unzipping C:\Documents and Settings\Claudia\.gradle\wrapper\dists\gradle-5.0-all\ac27o8rbd0ic8ih41or9l32mv\gradle-5.0-all.zip to C:\Documents and Settings\Claudia\.gradle\wrapper\dists\gradle-5.0-al\ac27o8rbd0ic8ih41or9l32mv Set executable permissions for: C:\Documents and Settings\Claudia\.gradle\wrapper\dists\gradle-5.0-all\ac27o8rbd0ic8ih41or9l32mv\gradle-5.0\bin\gradle BUILD SUCCESSFUL in 12s 1 actionable task: 1 executed

请参阅Gradle Wrapper 参考以了解更多信息。

下一步: 了解 Gradle CLI >>

命令行界面基础知识

命令行界面是在 IDE 之外与 Gradle 交互的主要方法。

强烈鼓励使用Gradle Wrapper 。

在以下示例中替换为./gradlew(在 macOS / Linux 中)或gradlew.bat(在 Windows 中) 。gradle

在命令行执行Gradle符合以下结构:

gradle [taskName...] [--option-name...]

任务名称之前和之后允许使用选项。

gradle [--option-name...] [taskName...]

如果指定了多个任务,则应该用空格分隔它们。

gradle [taskName1 taskName2...] [--option-name...]

接受值的选项可以=在选项和参数之间指定,也可以不指定。=推荐使用。

gradle [...] --console=plain

启用行为的选项具有长格式选项,其逆值用 指定--no-。以下是相反的情况。

gradle [...] --build-cache gradle [...] --no-build-cache

许多长期权都有相应的短期权。以下是等效的:

gradle --help gradle -h

设置文件基础知识

设置文件是每个 Gradle 项目的入口点。

设置文件的主要目的是将子项目添加到您的构建中。

Gradle 支持单项目和多项目构建。

-

对于单项目构建,设置文件是可选的。

-

对于多项目构建,设置文件是必需的并声明所有子项目。

设置脚本

设置文件是一个脚本。它可以是settings.gradle用 Groovy 编写的文件,也可以是settings.gradle.kts用 Kotlin 编写的文件。

Groovy DSL和Kotlin DSL是 Gradle 脚本唯一接受的语言。

设置文件通常位于项目的根目录中。

让我们看一个例子并将其分解:

rootProject.name = "root-project" // (1)

include("sub-project-a") // (2)

include("sub-project-b")

include("sub-project-c")-

Define the project name.

-

Add subprojects.

rootProject.name = 'root-project' // (1)

include('sub-project-a') // (2)

include('sub-project-b')

include('sub-project-c')-

Define the project name.

-

Add subprojects.

构建文件基础知识

一般来说,构建脚本详细介绍了构建配置、任务和插件。

每个 Gradle 构建至少包含一个构建脚本。

在构建文件中,可以添加两种类型的依赖项:

-

Gradle 和构建脚本所依赖的库和/或插件。

-

项目源(即源代码)所依赖的库。

构建脚本

构建脚本可以是build.gradle用 Groovy 编写的文件,也可以是build.gradle.kts用 Kotlin 编写的文件。

Groovy DSL和Kotlin DSL是 Gradle 脚本唯一接受的语言。

让我们看一个例子并将其分解:

plugins {

id("application") // (1)

}

application {

mainClass = "com.example.Main" // (2)

}-

Add plugins.

-

Use convention properties.

plugins {

id 'application' // (1)

}

application {

mainClass = 'com.example.Main' // (2)

}-

Add plugins.

-

Use convention properties.

1.添加插件

插件扩展了 Gradle 的功能,并且可以向项目贡献任务。

将插件添加到构建中称为应用插件,并使附加功能可用。

plugins {

id("application")

}该application插件有助于创建可执行的 JVM 应用程序。

依赖管理基础知识

Gradle 内置了对依赖管理的支持。

依赖管理是一种用于声明和解析项目所需的外部资源的自动化技术。

Gradle 构建脚本定义了构建可能需要外部依赖项的项目的过程。依赖项是指支持构建项目的 JAR、插件、库或源代码。

版本目录

版本目录提供了一种将依赖项声明集中在libs.versions.toml文件中的方法。

该目录使子项目之间共享依赖关系和版本配置变得简单。它还允许团队在大型项目中强制执行库和插件的版本。

版本目录通常包含四个部分:

-

[versions] 声明插件和库将引用的版本号。

-

[libraries] 定义构建文件中使用的库。

-

[bundles] 定义一组依赖项。

-

[plugins] 定义插件。

[versions]

androidGradlePlugin = "7.4.1"

mockito = "2.16.0"

[libraries]

googleMaterial = { group = "com.google.android.material", name = "material", version = "1.1.0-alpha05" }

mockitoCore = { module = "org.mockito:mockito-core", version.ref = "mockito" }

[plugins]

androidApplication = { id = "com.android.application", version.ref = "androidGradlePlugin" }该文件位于该gradle目录中,以便 Gradle 和 IDE 自动使用它。应将版本目录签入源代码管理:gradle/libs.versions.toml。

声明你的依赖关系

要向项目添加依赖项,请在build.gradle(.kts)文件的依赖项块中指定依赖项。

以下build.gradle.kts文件使用上面的版本目录向项目添加一个插件和两个依赖项:

plugins {

alias(libs.plugins.androidApplication) // (1)

}

dependencies {

// Dependency on a remote binary to compile and run the code

implementation(libs.googleMaterial) // (2)

// Dependency on a remote binary to compile and run the test code

testImplementation(libs.mockitoCore) // (3)

}-

将 Android Gradle 插件应用于此项目,该项目添加了一些特定于构建 Android 应用程序的功能。

-

将材质依赖项添加到项目中。 Material Design 提供了用于在 Android 应用程序中创建用户界面的组件。该库将用于编译和运行本项目中的 Kotlin 源代码。

-

将 Mockito 依赖项添加到项目中。 Mockito 是一个用于测试 Java 代码的模拟框架。该库将用于编译和运行该项目中的测试源代码。

Gradle 中的依赖项按配置进行分组。

-

该

material库被添加到implementation配置中,用于编译和运行生产代码。 -

该

mockito-core库被添加到testImplementation配置中,用于编译和运行测试代码。

|

笔记

|

还有更多配置可供选择。 |

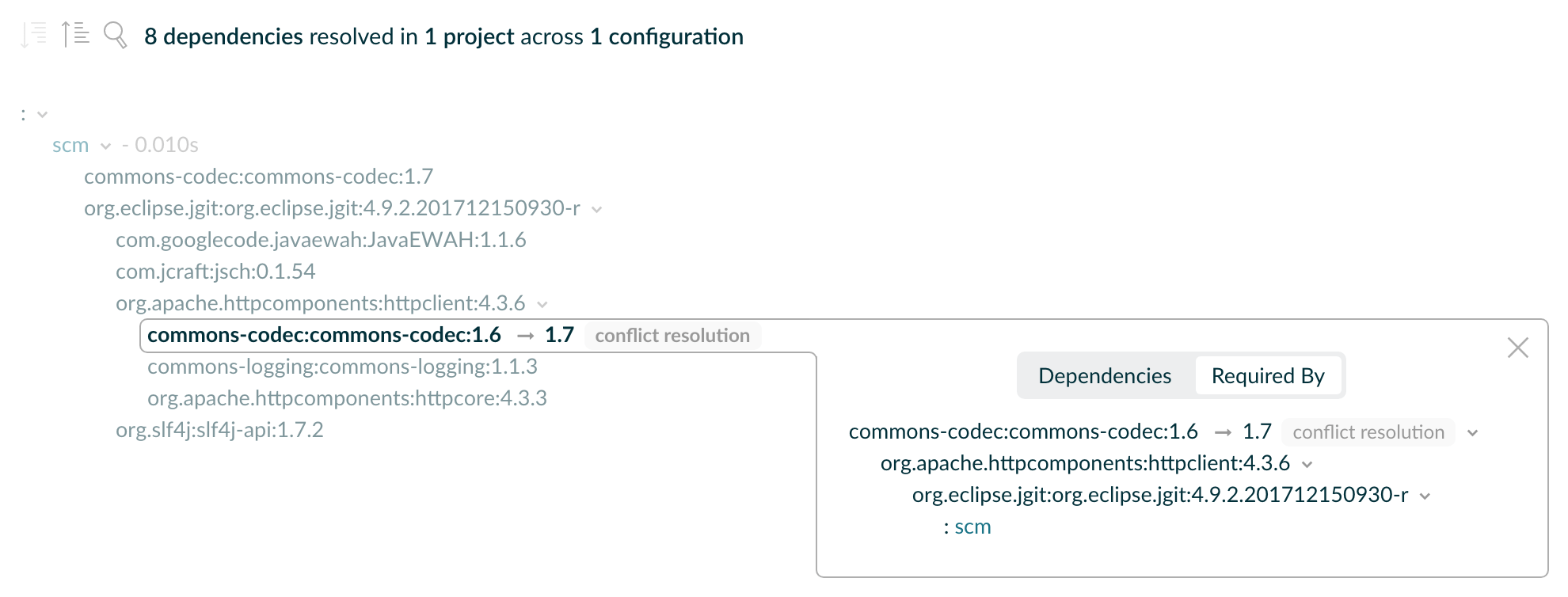

查看项目依赖关系

您可以使用以下命令在终端中查看依赖关系树./gradlew :app:dependencies:

$ ./gradlew :app:dependencies

> Task :app:dependencies

------------------------------------------------------------

Project ':app'

------------------------------------------------------------

implementation - Implementation only dependencies for source set 'main'. (n)

\--- com.google.android.material:material:1.1.0-alpha05 (n)

testImplementation - Implementation only dependencies for source set 'test'. (n)

\--- org.mockito:mockito-core:2.16.0 (n)

...请参阅依赖管理章节以了解更多信息。

下一步: 了解任务>>

任务基础知识

任务代表构建执行的某些独立工作单元,例如编译类、创建 JAR、生成 Javadoc 或将存档发布到存储库。

build您可以使用以下命令或通过调用项目目录中的gradleGradle Wrapper(./gradlew或)来运行 Gradle任务:gradlew.bat

$ ./gradlew build可用任务

项目中的所有可用任务都来自 Gradle 插件和构建脚本。

您可以通过在终端中运行以下命令来列出项目中的所有可用任务:

$ ./gradlew tasksApplication tasks

-----------------

run - Runs this project as a JVM application

Build tasks

-----------

assemble - Assembles the outputs of this project.

build - Assembles and tests this project.

...

Documentation tasks

-------------------

javadoc - Generates Javadoc API documentation for the main source code.

...

Other tasks

-----------

compileJava - Compiles main Java source.

...运行任务

该run任务的执行方式为./gradlew run:

$ ./gradlew run

> Task :app:compileJava

> Task :app:processResources NO-SOURCE

> Task :app:classes

> Task :app:run

Hello World!

BUILD SUCCESSFUL in 904ms

2 actionable tasks: 2 executed在此示例 Java 项目中,任务的输出run是Hello World打印在控制台上的语句。

任务依赖性

很多时候,一个任务需要先运行另一个任务。

例如,要让 Gradle 执行build任务,必须首先编译 Java 代码。因此,build任务取决于任务compileJava。

这意味着该任务将在以下任务之前compileJava运行:build

$ ./gradlew build

> Task :app:compileJava

> Task :app:processResources NO-SOURCE

> Task :app:classes

> Task :app:jar

> Task :app:startScripts

> Task :app:distTar

> Task :app:distZip

> Task :app:assemble

> Task :app:compileTestJava

> Task :app:processTestResources NO-SOURCE

> Task :app:testClasses

> Task :app:test

> Task :app:check

> Task :app:build

BUILD SUCCESSFUL in 764ms

7 actionable tasks: 7 executed构建脚本可以选择定义任务依赖关系。然后 Gradle 自动确定任务执行顺序。

请参阅任务开发章节以了解更多信息。

下一步: 了解插件>>

插件基础知识

Gradle 是建立在插件系统之上的。 Gradle 本身主要由基础设施组成,例如复杂的依赖解析引擎。它的其余功能来自插件。

插件是一个为 Gradle 构建系统提供附加功能的软件。

插件可以应用于 Gradle 构建脚本以添加新任务、配置或其他与构建相关的功能:

- Java 库插件 -

java-library -

用于定义和构建 Java 库。它随任务编译 Java 源代码

compileJava,随任务生成 Javadocjavadoc,并随任务将编译的类打包到 JAR 文件中jar。 - Google 服务 Gradle 插件 -

com.google.gms:google-services -

使用名为 的配置块

googleServices{}和名为 的任务在 Android 应用程序中启用 Google API 和 Firebase 服务generateReleaseAssets。 - Gradle Bintray 插件 -

com.jfrog.bintray -

允许您通过使用块配置插件来将工件发布到 Bintray

bintray{}。

插件分发

插件以三种方式分发:

-

核心插件- Gradle 开发并维护一组核心插件。

-

社区插件- Gradle 社区通过Gradle 插件门户共享插件。

-

本地插件- Gradle 使用户能够使用API创建自定义插件。

应用插件

将插件应用到项目允许插件扩展项目的功能。

您可以使用插件 ID(全局唯一标识符/名称)和版本在构建脚本中应用插件:

plugins {

id «plugin id» version «plugin version»

}1. 核心插件

Gradle Core 插件是 Gradle 发行版本身包含的一组插件。这些插件提供了构建和管理项目的基本功能。

核心插件的一些示例包括:

-

java:提供对构建 Java 项目的支持。

-

groovy:添加对编译和测试 Groovy 源文件的支持。

-

ear:添加了对为企业应用程序构建 EAR 文件的支持。

核心插件的独特之处在于,它们在构建脚本中应用时提供短名称,例如java核心JavaPlugin 。它们也不需要版本。要将java插件应用到项目中:

plugins {

id("java")

}用户可以利用许多Gradle 核心插件。

2. 社区插件

社区插件是由 Gradle 社区开发的插件,而不是核心 Gradle 发行版的一部分。这些插件提供可能特定于某些用例或技术的附加功能。

Spring Boot Gradle 插件打包可执行 JAR 或 WAR 档案,并运行Spring Boot Java 应用程序。

要将org.springframework.boot插件应用到项目中:

plugins {

id("org.springframework.boot") version "3.1.5"

}社区插件可以在Gradle 插件门户上发布,其他 Gradle 用户可以轻松发现和使用它们。

3.本地插件

自定义或本地插件是在特定项目或组织内开发和使用的。这些插件不会公开共享,而是根据项目或组织的特定需求量身定制的。

本地插件可以封装常见的构建逻辑,提供与内部系统或工具的集成,或者将复杂的功能抽象为可重用的组件。

Gradle 为用户提供了使用 API 开发自定义插件的能力。要创建您自己的插件,您通常需要遵循以下步骤:

-

定义插件类:创建一个实现接口的新类

Plugin<Project>。// Define a 'HelloPlugin' plugin class HelloPlugin : Plugin<Project> { override fun apply(project: Project) { // Define the 'hello' task val helloTask = project.tasks.register("hello") { doLast { println("Hello, Gradle!") } } } } -

构建并可选择发布您的插件:生成一个包含插件代码的 JAR 文件,并可选择将此 JAR 发布到存储库(本地或远程)以在其他项目中使用。

// Publish the plugin plugins { `maven-publish` } publishing { publications { create<MavenPublication>("mavenJava") { from(components["java"]) } } repositories { mavenLocal() } } -

应用您的插件:当您想要使用插件时,请在

plugins{}构建文件的块中包含插件 ID 和版本。// Apply the plugin plugins { id("com.example.hello") version "1.0" }

请参阅插件开发章节以了解更多信息。

下一步: 了解增量构建和构建缓存>>

Gradle 增量构建和构建缓存

Gradle 使用两个主要功能来减少构建时间:增量构建和构建缓存。

增量构建

增量构建是一种避免运行自上次构建以来输入未更改的任务的构建。如果这些任务只会重新产生相同的输出,则无需重新执行这些任务。

为了使增量构建发挥作用,任务必须定义其输入和输出。 Gradle 将确定输入或输出在构建时是否已更改。如果它们发生了变化,Gradle 将执行任务。否则,它将跳过执行。

增量构建始终处于启用状态,查看它们实际效果的最佳方法是打开详细模式。在详细模式下,每个任务状态在构建期间都会被标记:

$ ./gradlew compileJava --console=verbose

> Task :buildSrc:generateExternalPluginSpecBuilders UP-TO-DATE

> Task :buildSrc:extractPrecompiledScriptPluginPlugins UP-TO-DATE

> Task :buildSrc:compilePluginsBlocks UP-TO-DATE

> Task :buildSrc:generatePrecompiledScriptPluginAccessors UP-TO-DATE

> Task :buildSrc:generateScriptPluginAdapters UP-TO-DATE

> Task :buildSrc:compileKotlin UP-TO-DATE

> Task :buildSrc:compileJava NO-SOURCE

> Task :buildSrc:compileGroovy NO-SOURCE

> Task :buildSrc:pluginDescriptors UP-TO-DATE

> Task :buildSrc:processResources UP-TO-DATE

> Task :buildSrc:classes UP-TO-DATE

> Task :buildSrc:jar UP-TO-DATE

> Task :list:compileJava UP-TO-DATE

> Task :utilities:compileJava UP-TO-DATE

> Task :app:compileJava UP-TO-DATE

BUILD SUCCESSFUL in 374ms

12 actionable tasks: 12 up-to-date当您运行先前已执行且未更改的任务时,UP-TO-DATE任务旁边会打印 then 。

|

提示

|

要永久启用详细模式,请添加org.gradle.console=verbose到您的gradle.properties文件中。

|

构建缓存

增量构建是一种很好的优化,有助于避免已经完成的工作。如果开发人员不断更改单个文件,则可能不需要重建项目中的所有其他文件。

但是,当同一个开发人员切换到上周创建的新分支时会发生什么?即使开发人员正在构建以前构建过的东西,文件也会被重建。

这就是构建缓存有用的地方。

构建缓存存储以前的构建结果并在需要时恢复它们。它可以防止执行耗时且昂贵的流程的冗余工作和成本。

当构建缓存已用于重新填充本地目录时,任务将标记为FROM-CACHE:

$ ./gradlew compileJava --build-cache

> Task :buildSrc:generateExternalPluginSpecBuilders UP-TO-DATE

> Task :buildSrc:extractPrecompiledScriptPluginPlugins UP-TO-DATE

> Task :buildSrc:compilePluginsBlocks UP-TO-DATE

> Task :buildSrc:generatePrecompiledScriptPluginAccessors UP-TO-DATE

> Task :buildSrc:generateScriptPluginAdapters UP-TO-DATE

> Task :buildSrc:compileKotlin UP-TO-DATE

> Task :buildSrc:compileJava NO-SOURCE

> Task :buildSrc:compileGroovy NO-SOURCE

> Task :buildSrc:pluginDescriptors UP-TO-DATE

> Task :buildSrc:processResources UP-TO-DATE

> Task :buildSrc:classes UP-TO-DATE

> Task :buildSrc:jar UP-TO-DATE

> Task :list:compileJava FROM-CACHE

> Task :utilities:compileJava FROM-CACHE

> Task :app:compileJava FROM-CACHE

BUILD SUCCESSFUL in 364ms

12 actionable tasks: 3 from cache, 9 up-to-date重新填充本地目录后,下一次执行会将任务标记为UP-TO-DATE而不是FROM-CACHE。

构建缓存允许您跨团队共享和重用未更改的构建和测试输出。这加快了本地和 CI 构建的速度,因为不会浪费周期来重新构建不受新代码更改影响的二进制文件。

请参阅“构建缓存”一章以了解更多信息。

下一步: 了解构建扫描>>

其他主题

持续构建

持续构建允许您在文件输入更改时自动重新执行请求的任务。您可以使用-t或--continuous命令行选项在此模式下执行构建。

例如,您可以test通过运行以下命令连续运行该任务和所有相关任务:

$ gradle test --continuous

gradle testGradle 的行为就像您在更改有助于请求任务的源或测试后运行一样。这意味着不相关的更改(例如对构建脚本的更改)将不会触发重建。要合并构建逻辑更改,必须手动重新启动连续构建。

持续构建使用文件系统监视来检测输入的更改。如果文件系统监视在您的系统上不起作用,那么连续构建也将不起作用。特别是,使用时连续构建不起作用--no-daemon。

当 Gradle 检测到输入发生更改时,它不会立即触发构建。相反,它将等待一段时间(安静期),直到没有检测到任何其他更改。您可以通过 Gradle 属性以毫秒为单位配置安静期org.gradle.continuous.quietperiod。

终止持续构建

如果 Gradle 连接到交互式输入源(例如终端),则可以通过按退出连续构建CTRL-D(在 Microsoft Windows 上,还需要按ENTER或RETURN之后CTRL-D)。

如果 Gradle 未附加到交互式输入源(例如作为脚本的一部分运行),则必须终止构建过程(例如使用命令kill或类似命令)。

如果通过 Tooling API 执行构建,则可以使用 Tooling API 的取消机制取消构建。

局限性

在某些情况下,连续构建可能无法检测输入的更改。

创建输入目录

有时,由于文件系统监视的工作方式,创建以前丢失的输入目录不会触发构建。例如,创建src/main/java目录可能不会触发构建。同样,如果输入是经过筛选的文件树,并且没有文件与筛选器匹配,则匹配文件的创建可能不会触发构建。

对项目目录之外的文件进行更改

Gradle 仅监视项目目录内文件的更改。对项目目录外部文件的更改将不会被检测到,并且不会触发构建。

构建周期

Gradle 在任务执行之前开始监视更改。如果任务在执行时修改了自己的输入,Gradle 将检测到更改并触发新的构建。如果每次任务执行时,再次修改输入,则会再次触发构建。这并不是持续构建所独有的。在没有持续构建的情况下“正常”运行时,修改其自身输入的任务永远不会被认为是最新的。

如果您的构建进入这样的构建周期,您可以通过查看 Gradle 报告的更改的文件列表来跟踪任务。识别出每次构建期间更改的文件后,您应该查找将该文件作为输入的任务。在某些情况下,这可能是显而易见的(例如,Java 文件是用 编译的compileJava)。在其他情况下,您可以使用--info日志记录来查找由于识别的文件而过期的任务。

基础

摇篮目录

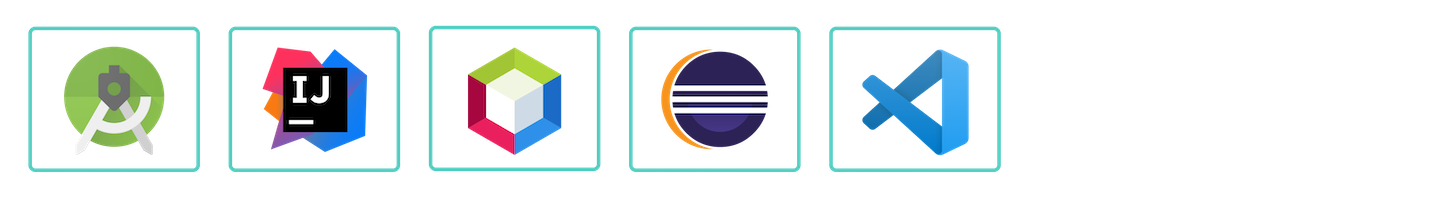

Gradle 使用两个主要目录来执行和管理其工作:Gradle 用户主目录和项目根目录。

Gradle 用户主目录

默认情况下,Gradle 用户主页(~/.gradle或C:\Users\<USERNAME>\.gradle)存储全局配置属性、初始化脚本、缓存和日志文件。

可以通过环境变量来设置GRADLE_USER_HOME。

|

提示

|

GRADLE_HOME不要与Gradle 的可选安装目录

混淆。 |

其结构大致如下:

├── caches // (1) │ ├── 4.8 // (2) │ ├── 4.9 // (2) │ ├── ⋮ │ ├── jars-3 // (3) │ └── modules-2 // (3) ├── daemon // (4) │ ├── ⋮ │ ├── 4.8 │ └── 4.9 ├── init.d // (5) │ └── my-setup.gradle ├── jdks // (6) │ ├── ⋮ │ └── jdk-14.0.2+12 ├── wrapper │ └── dists // (7) │ ├── ⋮ │ ├── gradle-4.8-bin │ ├── gradle-4.9-all │ └── gradle-4.9-bin └── gradle.properties // (8)

-

全局缓存目录(用于所有非项目特定的内容)。

-

版本特定的缓存(例如,支持增量构建)。

-

共享缓存(例如,用于依赖项的工件)。

-

Gradle Daemon的注册表和日志。

-

全局初始化脚本。

-

通过工具链支持下载的 JDK 。

-

由Gradle Wrapper下载的发行版。

-

全局Gradle 配置属性。

请参阅Gradle 目录参考以了解更多信息。

项目根目录

项目根目录包含项目中的所有源文件。

它还包含 Gradle 生成的文件和目录,例如.gradle和build。

虽然.gradle通常会签入源代码管理,但该build目录包含构建的输出以及 Gradle 用于支持增量构建等功能的临时文件。

典型项目根目录的剖析如下:

├── .gradle // (1) │ ├── 4.8 // (2) │ ├── 4.9 // (2) │ └── ⋮ ├── build // (3) ├── gradle │ └── wrapper // (4) ├── gradle.properties // (5) ├── gradlew // (6) ├── gradlew.bat // (6) ├── settings.gradle.kts // (7) ├── subproject-one // (8) | └── build.gradle.kts // (9) ├── subproject-two // (8) | └── build.gradle.kts // (9) └── ⋮

-

Gradle 生成的项目特定的缓存目录。

-

版本特定的缓存(例如,支持增量构建)。

-

该项目的构建目录,Gradle 在其中生成所有构建工件。

-

包含Gradle Wrapper的 JAR 文件和配置。

-

项目特定的Gradle 配置属性。

-

使用Gradle Wrapper执行构建的脚本。

-

定义子项目列表的项目设置文件。

-

通常,一个项目被组织成一个或多个子项目。

-

每个子项目都有自己的 Gradle 构建脚本。

请参阅Gradle 目录参考以了解更多信息。

下一步: 了解如何构建多项目构建>>

多项目构建基础知识

Gradle 支持多项目构建。

虽然一些小型项目和整体应用程序可能包含单个构建文件和源代码树,但更常见的情况是项目被分割成更小的、相互依赖的模块。 “相互依赖”这个词至关重要,因为您通常希望通过单个构建将许多模块链接在一起。

Gradle 通过多项目构建支持这种场景。这有时被称为多模块项目。 Gradle 将模块称为子项目。

多项目构建由一个根项目和一个或多个子项目组成。

多项目结构

以下表示包含两个子项目的多项目构建的结构:

目录结构应如下所示:

├── .gradle

│ └── ⋮

├── gradle

│ ├── libs.version.toml

│ └── wrapper

├── gradlew

├── gradlew.bat

├── settings.gradle.kts // (1)

├── sub-project-1

│ └── build.gradle.kts // (2)

├── sub-project-2

│ └── build.gradle.kts // (2)

└── sub-project-3

└── build.gradle.kts // (2)

-

该

settings.gradle.kts文件应包含所有子项目。 -

每个子项目都应该有自己的

build.gradle.kts文件。

多项目标准

Gradle 社区对于多项目构建结构有两个标准:

-

使用 buildSrc 进行多项目构建- 其中

buildSrc是 Gradle 项目根目录中包含所有构建逻辑的类似子项目的目录。 -

复合构建- 包含其他构建的构建,其中

build-logic包含可重用构建逻辑的 Gradle 项目根目录中的构建目录。

1. 多项目构建使用buildSrc

多项目构建允许您组织具有许多模块的项目,连接这些模块之间的依赖关系,并轻松地在它们之间共享通用的构建逻辑。

例如,一个包含许多名为mobile-app、web-app、api、lib、的模块的构建documentation可以按如下方式构建:

.

├── gradle

├── gradlew

├── settings.gradle.kts

├── buildSrc

│ ├── build.gradle.kts

│ └── src/main/kotlin/shared-build-conventions.gradle.kts

├── mobile-app

│ └── build.gradle.kts

├── web-app

│ └── build.gradle.kts

├── api

│ └── build.gradle.kts

├── lib

│ └── build.gradle.kts

└── documentation

└── build.gradle.kts这些模块之间将具有依赖关系,例如web-app和mobile-appdependent on lib。这意味着为了让 Gradle 构建web-app或mobile-app,它必须lib首先构建。

在此示例中,根设置文件将如下所示:

include("mobile-app", "web-app", "api", "lib", "documentation")|

笔记

|

子项目(模块)的包含顺序并不重要。 |

buildSrcGradle 会自动识别该目录。它是定义和维护共享配置或命令式构建逻辑(例如自定义任务或插件)的好地方。

buildSrc如果build.gradle(.kts)在buildSrc.

如果java插件应用于buildSrc项目,则编译后的代码buildSrc/src/main/java将放入根构建脚本的类路径中,使其可用于构建中的任何子项目( web-app、mobile-app、等...)。lib

请参阅如何声明子项目之间的依赖关系以了解更多信息。

2. 复合构建

复合构建,也称为包含构建,最适合在构建(而不是子项目)之间共享逻辑或隔离对共享构建逻辑(即约定插件)的访问。

让我们以前面的例子为例。其中的逻辑buildSrc已转变为包含插件的项目,并且可以独立于根项目构建进行发布和工作。

build-logic该插件被移动到使用构建脚本和设置文件调用的自己的构建中:

.

├── gradle

├── gradlew

├── settings.gradle.kts

├── build-logic

│ ├── settings.gradle.kts

│ └── conventions

│ ├── build.gradle.kts

│ └── src/main/kotlin/shared-build-conventions.gradle.kts

├── mobile-app

│ └── build.gradle.kts

├── web-app

│ └── build.gradle.kts

├── api

│ └── build.gradle.kts

├── lib

│ └── build.gradle.kts

└── documentation

└── build.gradle.kts|

笔记

|

build-logic位于根项目的子目录中

的事实是无关紧要的。如果需要,该文件夹可以位于根项目之外。

|

根设置文件包括整个build-logic 构建:

pluginManagement {

includeBuild("build-logic")

}

include("mobile-app", "web-app", "api", "lib", "documentation")请参阅如何创建复合构建以includeBuild了解更多信息。

多项目路径

项目路径具有以下模式:它以可选的冒号开头,表示根项目。

根项目:是路径中唯一未按其名称指定的项目。

项目路径的其余部分是用冒号分隔的项目名称序列,其中下一个项目是上一个项目的子项目:

:sub-project-1运行时可以看到项目路径gradle projects:

------------------------------------------------------------

Root project 'project'

------------------------------------------------------------

Root project 'project'

+--- Project ':sub-project-1'

\--- Project ':sub-project-2'项目路径通常反映文件系统布局,但也有例外。最显着的是复合构建。

确定项目结构

您可以使用该gradle projects命令来识别项目结构。

作为示例,让我们使用具有以下结构的多项目构建:

> gradle -q projects

------------------------------------------------------------ Root project 'multiproject' ------------------------------------------------------------ Root project 'multiproject' +--- Project ':api' +--- Project ':services' | +--- Project ':services:shared' | \--- Project ':services:webservice' \--- Project ':shared' To see a list of the tasks of a project, run gradle <project-path>:tasks For example, try running gradle :api:tasks

多项目构建是您可以运行的任务的集合。不同之处在于您可能想要控制执行哪个项目的任务。

以下部分将介绍在多项目构建中执行任务的两个选项。

按名称执行任务

该命令将在相对于具有该任务的当前工作目录的任何子项目中gradle test执行该任务。test

如果从项目根目录运行该命令,您将test在api、shared、services:shared和services:webservice中运行。

如果从services项目目录运行命令,则只会执行services:shared和services:webservice中的任务。

Gradle 行为背后的基本规则是使用该名称执行层次结构中的所有任务。如果在遍历的任何子项目中都没有找到这样的任务,则进行抱怨。

|

笔记

|

某些任务选择器(例如help或dependencies)只会在调用它们的项目上运行任务,而不是在所有子项目上运行,以减少屏幕上打印的信息量。

|

通过完全限定名称执行任务

您可以使用任务的完全限定名称来执行特定子项目中的特定任务。例如:gradle :services:webservice:build将运行webservicebuild子项目的任务。

任务的完全限定名称是其项目路径加上任务名称。

这种方法适用于任何任务,因此如果您想知道特定子项目中有哪些任务,请使用任务tasks,例如gradle :services:webservice:tasks。

多项目构建和测试

该build任务通常用于编译、测试和检查单个项目。

在多项目构建中,您可能经常希望跨多个项目执行所有这些任务。和buildNeeded任务buildDependents可以帮助解决这个问题。

在此示例中,:services:person-service项目同时依赖于:api和:shared项目。项目:api也要看:shared项目。

假设您正在处理单个项目,即该:api项目,您一直在进行更改,但自从执行clean.您想要构建任何必要的支持 JAR,但仅对已更改的项目部分执行代码质量和单元测试。

该build任务执行以下操作:

$ gradle :api:build > Task :shared:compileJava > Task :shared:processResources > Task :shared:classes > Task :shared:jar > Task :api:compileJava > Task :api:processResources > Task :api:classes > Task :api:jar > Task :api:assemble > Task :api:compileTestJava > Task :api:processTestResources > Task :api:testClasses > Task :api:test > Task :api:check > Task :api:build BUILD SUCCESSFUL in 0s

如果您刚刚从版本控制系统获取了最新版本的源代码,其中包括:api依赖的其他项目中的更改,您可能想要构建您依赖的所有项目并测试它们。

该buildNeeded任务构建并测试配置的项目依赖项中的所有项目testRuntime:

$ gradle :api:buildNeeded > Task :shared:compileJava > Task :shared:processResources > Task :shared:classes > Task :shared:jar > Task :api:compileJava > Task :api:processResources > Task :api:classes > Task :api:jar > Task :api:assemble > Task :api:compileTestJava > Task :api:processTestResources > Task :api:testClasses > Task :api:test > Task :api:check > Task :api:build > Task :shared:assemble > Task :shared:compileTestJava > Task :shared:processTestResources > Task :shared:testClasses > Task :shared:test > Task :shared:check > Task :shared:build > Task :shared:buildNeeded > Task :api:buildNeeded BUILD SUCCESSFUL in 0s

您可能想要重构:api其他项目中使用的项目的某些部分。如果进行这些更改,仅测试:api项目是不够的。您必须测试依赖于该:api项目的所有项目。

该buildDependents任务测试对指定项目具有项目依赖性(在 testRuntime 配置中)的所有项目:

$ gradle :api:buildDependents > Task :shared:compileJava > Task :shared:processResources > Task :shared:classes > Task :shared:jar > Task :api:compileJava > Task :api:processResources > Task :api:classes > Task :api:jar > Task :api:assemble > Task :api:compileTestJava > Task :api:processTestResources > Task :api:testClasses > Task :api:test > Task :api:check > Task :api:build > Task :services:person-service:compileJava > Task :services:person-service:processResources > Task :services:person-service:classes > Task :services:person-service:jar > Task :services:person-service:assemble > Task :services:person-service:compileTestJava > Task :services:person-service:processTestResources > Task :services:person-service:testClasses > Task :services:person-service:test > Task :services:person-service:check > Task :services:person-service:build > Task :services:person-service:buildDependents > Task :api:buildDependents BUILD SUCCESSFUL in 0s

最后,您可以构建和测试所有项目中的所有内容。您在根项目文件夹中运行的任何任务都将导致该同名任务在所有子项目上运行。

您可以运行gradle build来构建和测试所有项目。

请参阅构建构建章节以了解更多信息。

下一步: 了解 Gradle 构建生命周期>>

构建生命周期

作为构建作者,您可以定义任务以及任务之间的依赖关系。 Gradle 保证这些任务将按照其依赖关系的顺序执行。

您的构建脚本和插件配置此依赖关系图。

例如,如果您的项目任务包括build、assemble、createDocs,您的构建脚本可以确保它们按照build→ assemble→ 的顺序执行createDoc。

任务图

Gradle 在执行任何任务之前构建任务图。

在构建中的所有项目中,任务形成有向无环图(DAG)。

该图显示了两个示例任务图,一个是抽象的,另一个是具体的,任务之间的依赖关系用箭头表示:

插件和构建脚本都通过任务依赖机制和带注释的输入/输出对任务图做出贡献。

构建阶段

Gradle 构建具有三个不同的阶段。

Gradle 按顺序运行这些阶段:

- 第 1 阶段. 初始化

- 第 2 阶段. 配置

-

-

build.gradle(.kts)评估参与构建的每个项目的构建脚本。 -

为请求的任务创建任务图。

-

- 第三阶段:执行

-

-

安排并执行选定的任务。

-

任务之间的依赖关系决定了执行顺序。

-

任务的执行可以并行发生。

-

例子

以下示例显示了设置和构建文件的哪些部分对应于各个构建阶段:

rootProject.name = "basic"

println("This is executed during the initialization phase.")println("This is executed during the configuration phase.")

tasks.register("configured") {

println("This is also executed during the configuration phase, because :configured is used in the build.")

}

tasks.register("test") {

doLast {

println("This is executed during the execution phase.")

}

}

tasks.register("testBoth") {

doFirst {

println("This is executed first during the execution phase.")

}

doLast {

println("This is executed last during the execution phase.")

}

println("This is executed during the configuration phase as well, because :testBoth is used in the build.")

}rootProject.name = 'basic'

println 'This is executed during the initialization phase.'println 'This is executed during the configuration phase.'

tasks.register('configured') {

println 'This is also executed during the configuration phase, because :configured is used in the build.'

}

tasks.register('test') {

doLast {

println 'This is executed during the execution phase.'

}

}

tasks.register('testBoth') {

doFirst {

println 'This is executed first during the execution phase.'

}

doLast {

println 'This is executed last during the execution phase.'

}

println 'This is executed during the configuration phase as well, because :testBoth is used in the build.'

}以下命令执行上面指定的test和testBoth任务。由于 Gradle 仅配置请求的任务及其依赖项,因此configured任务从不配置:

> gradle test testBoth

This is executed during the initialization phase.

> Configure project :

This is executed during the configuration phase.

This is executed during the configuration phase as well, because :testBoth is used in the build.

> Task :test

This is executed during the execution phase.

> Task :testBoth

This is executed first during the execution phase.

This is executed last during the execution phase.

BUILD SUCCESSFUL in 0s

2 actionable tasks: 2 executed> gradle test testBoth

This is executed during the initialization phase.

> Configure project :

This is executed during the configuration phase.

This is executed during the configuration phase as well, because :testBoth is used in the build.

> Task :test

This is executed during the execution phase.

> Task :testBoth

This is executed first during the execution phase.

This is executed last during the execution phase.

BUILD SUCCESSFUL in 0s

2 actionable tasks: 2 executed第 1 阶段. 初始化

在初始化阶段,Gradle 检测项目集(根项目和子项目)并包含参与构建的构建。

Gradle 首先评估设置文件,settings.gradle(.kts)并实例化一个Settings对象。然后,Gradle 实例化Project每个项目的实例。

第 2 阶段. 配置

在配置阶段,Gradle 将任务和其他属性添加到初始化阶段找到的项目中。

写入设置文件

设置文件是每个 Gradle 构建的入口点。

找到设置文件后settings.gradle(.kts),Gradle 会实例化一个Settings对象。

该对象的用途之一Settings是允许您声明要包含在构建中的所有项目。

设置脚本

设置脚本可以是settings.gradleGroovy 中的文件,也可以是settings.gradle.ktsKotlin 中的文件。

在 Gradle 组装项目进行构建之前,它会创建一个Settings实例并针对它执行设置文件。

当设置脚本执行时,它会配置此Settings.因此,设置文件定义了该Settings对象。

|

重要的

|

Settings实例和文件

之间存在一一对应的关系settings.gradle(.kts)。

|

物体Settings

该对象是Gradle APISettings的一部分。

设置脚本中的许多顶级属性和块都是设置 API 的一部分。

例如,我们可以使用以下属性在设置脚本中设置根项目名称Settings.rootProject:

settings.rootProject.name = "root"通常缩写为:

rootProject.name = "root"标准Settings特性

该Settings对象在您的设置脚本中公开一组标准属性。

下表列出了一些常用的属性:

| 姓名 | 描述 |

|---|---|

|

构建缓存配置。 |

|

已应用于设置的插件的容器。 |

|

构建的根目录。根目录是根项目的项目目录。 |

|

构建的根项目。 |

|

返回此设置对象。 |

下表列出了几种常用的方法:

| 姓名 | 描述 |

|---|---|

|

将给定的项目添加到构建中。 |

|

包括复合构建的指定路径处的构建。 |

设置脚本结构

设置脚本是对 Gradle API 的一系列方法调用,通常使用{ … },这是 Groovy 和 Kotlin 语言中的特殊快捷方式。块在 Kotlin 中{ }称为lambda ,在 Groovy 中称为闭包。

简而言之,该plugins{ }块是一个方法调用,其中传递 Kotlin lambda对象或 Groovy闭包对象作为参数。它的缩写形式是:

plugins(function() {

id("plugin")

})块映射到 Gradle API 方法。

函数内的代码针对一个对象执行,该对象在 Kotlin lambda 中this称为接收器,在 Groovy 闭包中称为委托。 Gradle 确定正确的this对象并调用正确的相应方法。this方法调用对象的 的类型id("plugin")为PluginDependenciesSpec。

设置文件由构建在 DSL 之上的 Gradle API 调用组成。 Gradle 从上到下逐行执行脚本。

让我们看一个例子并将其分解:

pluginManagement { // (1)

repositories {

gradlePluginPortal()

google()

}

}

plugins { // (2)

id("org.gradle.toolchains.fake") version "0.6.0"

}

rootProject.name = "root-project" // (3)

dependencyResolutionManagement { // (4)

repositories {

mavenCentral()

}

}

include("sub-project-a") // (5)

include("sub-project-b")

include("sub-project-c")-

Define the location of plugins

-

Apply plugins.

-

Define the root project name.

-

Define build-wide repositories.

-

Add subprojects to the build.

pluginManagement { // (1)

repositories {

gradlePluginPortal()

google()

}

}

plugins { // (2)

id 'org.gradle.toolchains.fake' version '0.6.0'

}

rootProject.name = 'root-project' // (3)

dependencyResolutionManagement { // (4)

repositories {

mavenCentral()

}

}

include('sub-project-a') // (5)

include('sub-project-b')

include('sub-project-c')-

Define the location of plugins.

-

Apply plugins.

-

Define the root project name.

-

Define build-wide repositories.

-

Add subprojects to the build.

1.定义插件的位置

设置文件可以选择定义您的项目使用的插件pluginManagement,包括二进制存储库,例如 Gradle 插件门户或其他使用以下 Gradle 构建includeBuild:

pluginManagement {

repositories {

gradlePluginPortal()

google()

}

}您还可以在此块中包含插件和插件依赖项解析策略。

2. 应用插件

设置文件可以选择声明稍后可能应用的插件,这可以在多个构建/子项目之间添加共享配置:

应用于设置的插件仅影响Settings对象。

plugins {

id("org.gradle.toolchains.fake") version "0.6.0"

}这通常用于确保所有子项目使用相同的插件版本。

4. 定义构建范围的存储库

设置文件可以选择使用 Maven Central 等二进制存储库和/或其他 Gradle 构建来定义项目所依赖的组件的位置(以及如何解析它们):repositoriesincludeBuild

dependencyResolutionManagement {

repositories {

mavenCentral()

}

}您还可以在此部分中包含版本目录。

5. 将子项目添加到构建中

设置文件通过使用以下语句添加所有子项目来定义项目的结构include:

include("app")

include("business-logic")

include("data-model")设置文件脚本

该对象还有更多属性和方法Settings可用于配置构建。

重要的是要记住,虽然许多 Gradle 脚本通常是用简短的 Groovy 或 Kotlin 语法编写的,但设置脚本中的每个项目本质上都是调用SettingsGradle API 中对象的方法:

include("app")实际上是:

settings.include("app")此外,您还可以使用 Groovy 和 Kotlin 语言的全部功能。

例如,include您可以迭代项目根文件夹中的目录列表并自动包含它们,而不是多次添加子项目:

rootDir.listFiles().filter { it.isDirectory && (new File(it, "build.gradle.kts").exists()) }.forEach {

include(it.name)

}|

提示

|

这种类型的逻辑应该在插件中开发。 |

下一步: 学习如何编写构建脚本>>

编写构建脚本

Gradle Build 生命周期中的初始化阶段使用设置文件查找项目根目录中包含的根项目和子项目。

然后,对于设置文件中包含的每个项目,Gradle 都会创建一个Project实例。

然后 Gradle 查找相应的构建脚本文件,该文件在配置阶段使用。

构建脚本

每个 Gradle 构建都包含一个或多个项目;根项目和子项目。

项目通常对应于需要构建的软件组件,例如库或应用程序。它可能代表一个库 JAR、一个 Web 应用程序或由其他项目生成的 JAR 组装而成的分发 ZIP。

另一方面,它可能代表要做的事情,例如将应用程序部署到临时或生产环境。

Gradle 脚本使用 Groovy DSL 或 Kotlin DSL(特定领域语言)编写。

构建脚本配置项目并与 类型的对象关联Project。

当构建脚本执行时,它会配置Project.

构建脚本可以是*.gradleGroovy 中的文件,也可以是*.gradle.ktsKotlin 中的文件。

|

重要的

|

构建脚本配置Project对象及其子对象。

|

物体Project

该对象是Gradle APIProject的一部分:

构建脚本中的许多顶级属性和块都是项目 API 的一部分。

例如,以下构建脚本使用Project.name属性来打印项目的名称:

println(name)

println(project.name)println name

println project.name$ gradle -q check project-api project-api

两个println语句都打印出相同的属性。

name第一个使用对象属性的顶级引用Project。第二条语句使用project可用于任何构建脚本的属性,该属性返回关联的Project对象。

标准项目属性

该Project对象在构建脚本中公开一组标准属性。

下表列出了一些常用的属性:

| 姓名 | 类型 | 描述 |

|---|---|---|

|

|

项目目录的名称。 |

|

|

项目的完全限定名称。 |

|

|

项目的描述。 |

|

|

返回项目的依赖处理程序。 |

|

|

返回项目的存储库处理程序。 |

|

|

提供对项目的几个重要位置的访问。 |

|

|

这个项目的小组。 |

|

|

该项目的版本。 |

下表列出了几种常用的方法:

| 姓名 | 描述 |

|---|---|

|

将文件路径解析为 URI,相对于该项目的项目目录。 |

|

使用给定名称创建一个任务并将其添加到此项目中。 |

构建脚本结构

{ … }Build 脚本由Groovy 和 Kotlin 中的一个特殊对象组成。该对象在 Kotlin 中称为lambda ,在 Groovy 中称为闭包。

简而言之,该plugins{ }块是一个方法调用,其中传递 Kotlin lambda对象或 Groovy闭包对象作为参数。它的缩写形式是:

plugins(function() {

id("plugin")

})块映射到 Gradle API 方法。

函数内的代码针对一个对象执行,该对象在 Kotlin lambda 中this称为接收器,在 Groovy 闭包中称为委托。 Gradle 确定正确的this对象并调用正确的相应方法。this方法调用对象的 的类型id("plugin")为PluginDependenciesSpec。

构建脚本本质上是由构建在 DSL 之上的 Gradle API 调用组成。 Gradle 从上到下逐行执行脚本。

让我们看一个例子并将其分解:

plugins { // (1)

id("org.jetbrains.kotlin.jvm") version "1.9.0"

id("application")

}

repositories { // (2)

mavenCentral()

}

dependencies { // (3)

testImplementation("org.jetbrains.kotlin:kotlin-test-junit5")

testImplementation("org.junit.jupiter:junit-jupiter-engine:5.9.3")

testRuntimeOnly("org.junit.platform:junit-platform-launcher")

implementation("com.google.guava:guava:32.1.1-jre")

}

application { // (4)

mainClass = "com.example.Main"

}

tasks.named<Test>("test") { // (5)

useJUnitPlatform()

}-

Apply plugins to the build.

-

Define the locations where dependencies can be found.

-

Add dependencies.

-

Set properties.

-

Register and configure tasks.

plugins { // (1)

id 'org.jetbrains.kotlin.jvm' version '1.9.0'

id 'application'

}

repositories { // (2)

mavenCentral()

}

dependencies { // (3)

testImplementation 'org.jetbrains.kotlin:kotlin-test-junit5'

testImplementation 'org.junit.jupiter:junit-jupiter-engine:5.9.3'

testRuntimeOnly 'org.junit.platform:junit-platform-launcher'

implementation 'com.google.guava:guava:32.1.1-jre'

}

application { // (4)

mainClass = 'com.example.Main'

}

tasks.named('test') { // (5)

useJUnitPlatform()

}-

Apply plugins to the build.

-

Define the locations where dependencies can be found.

-

Add dependencies.

-

Set properties.

-

Register and configure tasks.

1. 将插件应用到构建中

插件用于扩展 Gradle。它们还用于模块化和重用项目配置。

可以使用插件脚本块应用插件PluginDependenciesSpec。

插件块是首选:

plugins {

id("org.jetbrains.kotlin.jvm") version "1.9.0"

id("application")

}在示例中,application已应用 Gradle 附带的插件,将我们的项目描述为 Java 应用程序。

Kotlin gradle 插件 1.9.0 版本也已应用。该插件不包含在 Gradle 中,因此必须使用 aplugin id和 a进行描述plugin version,以便 Gradle 可以找到并应用它。

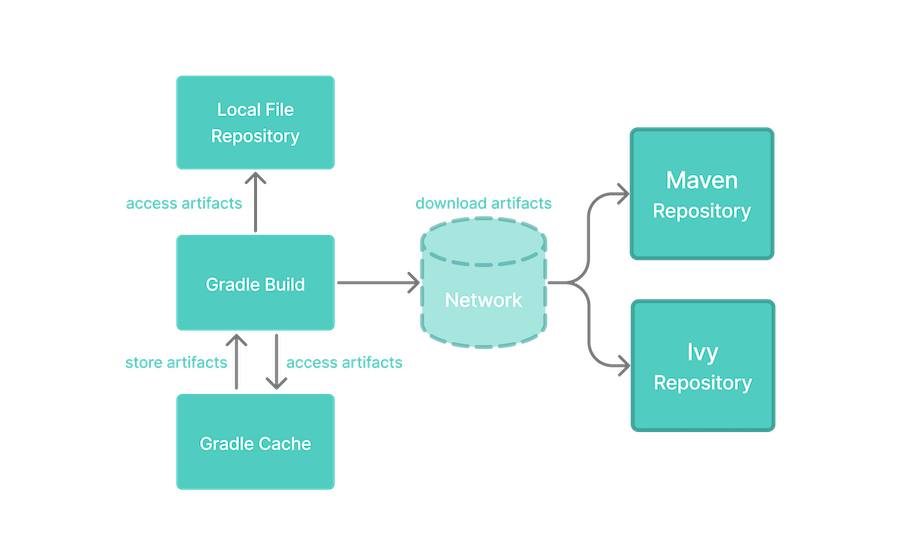

2.定义可以找到依赖的位置

一个项目通常具有完成其工作所需的许多依赖项。依赖项包括 Gradle 必须下载才能成功构建的插件、库或组件。

构建脚本让 Gradle 知道在哪里查找依赖项的二进制文件。可以提供多个位置:

repositories {

mavenCentral()

google()

}在示例中,将从Maven Central Repository下载guava库和 JetBrains Kotlin 插件 ( ) 。org.jetbrains.kotlin.jvm

3.添加依赖

一个项目通常具有完成其工作所需的许多依赖项。这些依赖项通常是在项目源代码中导入的预编译类的库。

依赖项通过配置进行管理并从存储库中检索。

使用DependencyHandlerbyProject.getDependencies()方法返回的值来管理依赖关系。使用RepositoryHandlerbyProject.getRepositories()方法返回来管理存储库。

dependencies {

implementation("com.google.guava:guava:32.1.1-jre")

}在示例中,应用程序代码使用 Google 的guava库。 Guava 提供了用于集合、缓存、原语支持、并发、通用注释、字符串处理、I/O 和验证的实用方法。

4. 设置属性

插件可以使用扩展向项目添加属性和方法。

该Project对象有一个关联ExtensionContainer对象,其中包含已应用于项目的插件的所有设置和属性。

在示例中,application插件添加了一个application属性,用于详细说明 Java 应用程序的主类:

application {

mainClass = "com.example.Main"

}5. 注册并配置任务

任务执行一些基本工作,例如编译类、运行单元测试或压缩 WAR 文件。

虽然任务通常在插件中定义,但您可能需要在构建脚本中注册或配置任务。

注册任务会将任务添加到您的项目中。

您可以使用以下方法在项目中注册任务TaskContainer.register(java.lang.String):

tasks.register<Zip>("zip-reports") {

from 'Reports/'

include '*'

archiveName 'Reports.zip'

destinationDir(file('/dir'))

}您可能已经看到了应该避免的TaskContainer.create(java.lang.String)方法的用法:

tasks.create<Zip>("zip-reports") {

from 'Reports/'

include '*'

archiveName 'Reports.zip'

destinationDir(file('/dir'))

}|

提示

|

register(),它可以避免任务配置,优于create().

|

您可以使用以下方法找到任务并对其进行配置TaskCollection.named(java.lang.String):

tasks.named<Test>("test") {

useJUnitPlatform()

}下面的示例将Javadoc任务配置为从 Java 代码自动生成 HTML 文档:

tasks.named("javadoc").configure {

exclude 'app/Internal*.java'

exclude 'app/internal/*'

exclude 'app/internal/*'

}构建脚本

构建脚本由零个或多个语句和脚本块组成:

println(project.layout.projectDirectory);语句可以包括方法调用、属性分配和局部变量定义:

version = '1.0.0.GA'脚本块是一个方法调用,它采用闭包/lambda 作为参数:

configurations {

}闭包/lambda 在执行时配置一些委托对象:

repositories {

google()

}构建脚本也是 Groovy 或 Kotlin 脚本:

tasks.register("upper") {

doLast {

val someString = "mY_nAmE"

println("Original: $someString")

println("Upper case: ${someString.toUpperCase()}")

}

}tasks.register('upper') {

doLast {

String someString = 'mY_nAmE'

println "Original: $someString"

println "Upper case: ${someString.toUpperCase()}"

}

}$ gradle -q upper Original: mY_nAmE Upper case: MY_NAME

它可以包含 Groovy 或 Kotlin 脚本中允许的元素,例如方法定义和类定义:

tasks.register("count") {

doLast {

repeat(4) { print("$it ") }

}

}tasks.register('count') {

doLast {

4.times { print "$it " }

}

}$ gradle -q count 0 1 2 3

灵活的任务注册

使用 Groovy 或 Kotlin 语言的功能,您可以在循环中注册多个任务:

repeat(4) { counter ->

tasks.register("task$counter") {

doLast {

println("I'm task number $counter")

}

}

}4.times { counter ->

tasks.register("task$counter") {

doLast {

println "I'm task number $counter"

}

}

}$ gradle -q task1 I'm task number 1

声明变量

构建脚本可以声明两个变量:局部变量和额外属性。

局部变量

使用关键字声明局部变量val。局部变量仅在声明它们的范围内可见。它们是底层 Kotlin 语言的一个功能。

使用关键字声明局部变量def。局部变量仅在声明它们的范围内可见。它们是底层 Groovy 语言的一个功能。

val dest = "dest"

tasks.register<Copy>("copy") {

from("source")

into(dest)

}def dest = 'dest'

tasks.register('copy', Copy) {

from 'source'

into dest

}额外属性

Gradle 的增强对象(包括项目、任务和源集)可以保存用户定义的属性。

通过所属对象的属性添加、读取和设置额外的属性extra。或者,您可以使用 .kotlin 委托属性来访问额外的属性by extra。

通过所属对象的属性添加、读取和设置额外的属性ext。或者,您可以使用ext块同时添加多个属性。

plugins {

id("java-library")

}

val springVersion by extra("3.1.0.RELEASE")

val emailNotification by extra { "build@master.org" }

sourceSets.all { extra["purpose"] = null }

sourceSets {

main {

extra["purpose"] = "production"

}

test {

extra["purpose"] = "test"

}

create("plugin") {

extra["purpose"] = "production"

}

}

tasks.register("printProperties") {

val springVersion = springVersion

val emailNotification = emailNotification

val productionSourceSets = provider {

sourceSets.matching { it.extra["purpose"] == "production" }.map { it.name }

}

doLast {

println(springVersion)

println(emailNotification)

productionSourceSets.get().forEach { println(it) }

}

}plugins {

id 'java-library'

}

ext {

springVersion = "3.1.0.RELEASE"

emailNotification = "build@master.org"

}

sourceSets.all { ext.purpose = null }

sourceSets {

main {

purpose = "production"

}

test {

purpose = "test"

}

plugin {

purpose = "production"

}

}

tasks.register('printProperties') {

def springVersion = springVersion

def emailNotification = emailNotification

def productionSourceSets = provider {

sourceSets.matching { it.purpose == "production" }.collect { it.name }

}

doLast {

println springVersion

println emailNotification

productionSourceSets.get().each { println it }

}

}$ gradle -q printProperties 3.1.0.RELEASE build@master.org main plugin

project此示例通过 向对象添加两个额外的属性by extra。此外,此示例purpose通过设置extra["purpose"]为为每个源集添加一个名为 的属性null。添加后,您可以通过读取和设置这些属性extra。

project此示例通过块向对象添加两个额外属性ext。此外,此示例purpose通过设置ext.purpose为为每个源集添加一个名为 的属性null。添加后,您可以像预定义的属性一样读取和设置所有这些属性。

Gradle 需要特殊的语法来添加属性,以便它可以快速失败。例如,这允许 Gradle 识别脚本何时尝试设置不存在的属性。您可以在任何可以访问其所属对象的地方访问额外的属性。这为额外属性提供了比局部变量更广泛的范围。子项目可以访问其父项目的额外属性。

有关额外属性的更多信息,请参阅 API 文档中的ExtraPropertiesExtension 。

配置任意对象

示例greet()任务显示了任意对象配置的示例:

class UserInfo(

var name: String? = null,

var email: String? = null

)

tasks.register("configure") {

val user = UserInfo().apply {

name = "Isaac Newton"

email = "isaac@newton.me"

}

doLast {

println(user.name)

println(user.email)

}

}class UserInfo {

String name

String email

}

tasks.register('configure') {

def user = configure(new UserInfo()) {

name = "Isaac Newton"

email = "isaac@newton.me"

}

doLast {

println user.name

println user.email

}

}$ gradle -q greet Isaac Newton isaac@newton.me

闭幕代表

每个闭包都有一个delegate对象。 Groovy 使用此委托来查找对非局部变量和闭包参数的变量和方法引用。 Gradle 将其用于配置闭包,其中delegate对象指的是正在配置的对象。

dependencies {

assert delegate == project.dependencies

testImplementation('junit:junit:4.13')

delegate.testImplementation('junit:junit:4.13')

}默认导入

为了使构建脚本更加简洁,Gradle 会自动向脚本添加一组 import 语句。

因此,throw new org.gradle.api.tasks.StopExecutionException()您可以不写throw new StopExecutionException()而是写。

Gradle 隐式地将以下导入添加到每个脚本中:

import org.gradle.*

import org.gradle.api.*

import org.gradle.api.artifacts.*

import org.gradle.api.artifacts.component.*

import org.gradle.api.artifacts.dsl.*

import org.gradle.api.artifacts.ivy.*

import org.gradle.api.artifacts.maven.*

import org.gradle.api.artifacts.query.*

import org.gradle.api.artifacts.repositories.*

import org.gradle.api.artifacts.result.*

import org.gradle.api.artifacts.transform.*

import org.gradle.api.artifacts.type.*

import org.gradle.api.artifacts.verification.*

import org.gradle.api.attributes.*

import org.gradle.api.attributes.java.*

import org.gradle.api.attributes.plugin.*

import org.gradle.api.cache.*

import org.gradle.api.capabilities.*

import org.gradle.api.component.*

import org.gradle.api.configuration.*

import org.gradle.api.credentials.*

import org.gradle.api.distribution.*

import org.gradle.api.distribution.plugins.*

import org.gradle.api.execution.*

import org.gradle.api.file.*

import org.gradle.api.flow.*

import org.gradle.api.initialization.*

import org.gradle.api.initialization.definition.*

import org.gradle.api.initialization.dsl.*

import org.gradle.api.initialization.resolve.*

import org.gradle.api.invocation.*

import org.gradle.api.java.archives.*

import org.gradle.api.jvm.*

import org.gradle.api.launcher.cli.*

import org.gradle.api.logging.*

import org.gradle.api.logging.configuration.*

import org.gradle.api.model.*

import org.gradle.api.plugins.*

import org.gradle.api.plugins.antlr.*

import org.gradle.api.plugins.catalog.*

import org.gradle.api.plugins.jvm.*

import org.gradle.api.plugins.quality.*

import org.gradle.api.plugins.scala.*

import org.gradle.api.problems.*

import org.gradle.api.provider.*

import org.gradle.api.publish.*

import org.gradle.api.publish.ivy.*

import org.gradle.api.publish.ivy.plugins.*

import org.gradle.api.publish.ivy.tasks.*

import org.gradle.api.publish.maven.*

import org.gradle.api.publish.maven.plugins.*

import org.gradle.api.publish.maven.tasks.*

import org.gradle.api.publish.plugins.*

import org.gradle.api.publish.tasks.*

import org.gradle.api.reflect.*

import org.gradle.api.reporting.*

import org.gradle.api.reporting.components.*

import org.gradle.api.reporting.dependencies.*

import org.gradle.api.reporting.dependents.*

import org.gradle.api.reporting.model.*

import org.gradle.api.reporting.plugins.*

import org.gradle.api.resources.*

import org.gradle.api.services.*

import org.gradle.api.specs.*

import org.gradle.api.tasks.*

import org.gradle.api.tasks.ant.*

import org.gradle.api.tasks.application.*

import org.gradle.api.tasks.bundling.*

import org.gradle.api.tasks.compile.*

import org.gradle.api.tasks.diagnostics.*

import org.gradle.api.tasks.diagnostics.configurations.*

import org.gradle.api.tasks.incremental.*

import org.gradle.api.tasks.javadoc.*

import org.gradle.api.tasks.options.*

import org.gradle.api.tasks.scala.*

import org.gradle.api.tasks.testing.*

import org.gradle.api.tasks.testing.junit.*

import org.gradle.api.tasks.testing.junitplatform.*

import org.gradle.api.tasks.testing.testng.*

import org.gradle.api.tasks.util.*

import org.gradle.api.tasks.wrapper.*

import org.gradle.api.toolchain.management.*

import org.gradle.authentication.*

import org.gradle.authentication.aws.*

import org.gradle.authentication.http.*

import org.gradle.build.event.*

import org.gradle.buildinit.*

import org.gradle.buildinit.plugins.*

import org.gradle.buildinit.tasks.*

import org.gradle.caching.*

import org.gradle.caching.configuration.*

import org.gradle.caching.http.*

import org.gradle.caching.local.*

import org.gradle.concurrent.*

import org.gradle.external.javadoc.*

import org.gradle.ide.visualstudio.*

import org.gradle.ide.visualstudio.plugins.*

import org.gradle.ide.visualstudio.tasks.*

import org.gradle.ide.xcode.*

import org.gradle.ide.xcode.plugins.*

import org.gradle.ide.xcode.tasks.*

import org.gradle.ivy.*

import org.gradle.jvm.*

import org.gradle.jvm.application.scripts.*

import org.gradle.jvm.application.tasks.*

import org.gradle.jvm.tasks.*

import org.gradle.jvm.toolchain.*

import org.gradle.language.*

import org.gradle.language.assembler.*

import org.gradle.language.assembler.plugins.*

import org.gradle.language.assembler.tasks.*

import org.gradle.language.base.*

import org.gradle.language.base.artifact.*

import org.gradle.language.base.compile.*

import org.gradle.language.base.plugins.*

import org.gradle.language.base.sources.*

import org.gradle.language.c.*

import org.gradle.language.c.plugins.*

import org.gradle.language.c.tasks.*

import org.gradle.language.cpp.*

import org.gradle.language.cpp.plugins.*

import org.gradle.language.cpp.tasks.*

import org.gradle.language.java.artifact.*

import org.gradle.language.jvm.tasks.*

import org.gradle.language.nativeplatform.*

import org.gradle.language.nativeplatform.tasks.*

import org.gradle.language.objectivec.*

import org.gradle.language.objectivec.plugins.*

import org.gradle.language.objectivec.tasks.*

import org.gradle.language.objectivecpp.*

import org.gradle.language.objectivecpp.plugins.*

import org.gradle.language.objectivecpp.tasks.*

import org.gradle.language.plugins.*

import org.gradle.language.rc.*

import org.gradle.language.rc.plugins.*

import org.gradle.language.rc.tasks.*

import org.gradle.language.scala.tasks.*

import org.gradle.language.swift.*

import org.gradle.language.swift.plugins.*

import org.gradle.language.swift.tasks.*

import org.gradle.maven.*

import org.gradle.model.*

import org.gradle.nativeplatform.*

import org.gradle.nativeplatform.platform.*

import org.gradle.nativeplatform.plugins.*

import org.gradle.nativeplatform.tasks.*

import org.gradle.nativeplatform.test.*

import org.gradle.nativeplatform.test.cpp.*

import org.gradle.nativeplatform.test.cpp.plugins.*

import org.gradle.nativeplatform.test.cunit.*

import org.gradle.nativeplatform.test.cunit.plugins.*

import org.gradle.nativeplatform.test.cunit.tasks.*

import org.gradle.nativeplatform.test.googletest.*

import org.gradle.nativeplatform.test.googletest.plugins.*

import org.gradle.nativeplatform.test.plugins.*

import org.gradle.nativeplatform.test.tasks.*

import org.gradle.nativeplatform.test.xctest.*

import org.gradle.nativeplatform.test.xctest.plugins.*

import org.gradle.nativeplatform.test.xctest.tasks.*

import org.gradle.nativeplatform.toolchain.*

import org.gradle.nativeplatform.toolchain.plugins.*

import org.gradle.normalization.*

import org.gradle.platform.*

import org.gradle.platform.base.*

import org.gradle.platform.base.binary.*

import org.gradle.platform.base.component.*

import org.gradle.platform.base.plugins.*

import org.gradle.plugin.devel.*

import org.gradle.plugin.devel.plugins.*

import org.gradle.plugin.devel.tasks.*

import org.gradle.plugin.management.*

import org.gradle.plugin.use.*

import org.gradle.plugins.ear.*

import org.gradle.plugins.ear.descriptor.*

import org.gradle.plugins.ide.*

import org.gradle.plugins.ide.api.*

import org.gradle.plugins.ide.eclipse.*

import org.gradle.plugins.ide.idea.*

import org.gradle.plugins.signing.*

import org.gradle.plugins.signing.signatory.*

import org.gradle.plugins.signing.signatory.pgp.*

import org.gradle.plugins.signing.type.*

import org.gradle.plugins.signing.type.pgp.*

import org.gradle.process.*

import org.gradle.swiftpm.*

import org.gradle.swiftpm.plugins.*

import org.gradle.swiftpm.tasks.*

import org.gradle.testing.base.*

import org.gradle.testing.base.plugins.*

import org.gradle.testing.jacoco.plugins.*

import org.gradle.testing.jacoco.tasks.*

import org.gradle.testing.jacoco.tasks.rules.*

import org.gradle.testkit.runner.*

import org.gradle.util.*

import org.gradle.vcs.*

import org.gradle.vcs.git.*

import org.gradle.work.*

import org.gradle.workers.*下一步: 了解如何使用任务>>

使用任务

Gradle 可以在项目上执行的工作由一项或多项任务定义。

任务代表构建执行的某些独立工作单元。这可能是编译一些类、创建 JAR、生成 Javadoc 或将一些档案发布到存储库。

当用户./gradlew build在命令行中运行时,Gradle 将执行该build任务及其依赖的任何其他任务。

列出可用任务

Gradle 为项目提供了几个默认任务,通过运行列出./gradlew tasks:

> Task :tasks

------------------------------------------------------------

Tasks runnable from root project 'myTutorial'

------------------------------------------------------------

Build Setup tasks

-----------------

init - Initializes a new Gradle build.

wrapper - Generates Gradle wrapper files.

Help tasks

----------

buildEnvironment - Displays all buildscript dependencies declared in root project 'myTutorial'.

...任务来自构建脚本或插件。

一旦我们将插件应用到我们的项目中,例如application插件,其他任务就变得可用:

plugins {

id("application")

}$ ./gradlew tasks

> Task :tasks

------------------------------------------------------------

Tasks runnable from project ':app'

------------------------------------------------------------

Application tasks

-----------------

run - Runs this project as a JVM application

Build tasks

-----------

assemble - Assembles the outputs of this project.

build - Assembles and tests this project.

Documentation tasks

-------------------

javadoc - Generates Javadoc API documentation for the main source code.

Other tasks

-----------

compileJava - Compiles main Java source.

...开发人员应该熟悉其中的许多任务,例如assemble、build、 和。run

任务分类

可以执行两类任务:

-

可操作的任务附加了一些操作来在您的构建中完成工作:

compileJava。 -

生命周期任务是没有附加操作的任务:

assemble,build。

通常,生命周期任务取决于许多可操作的任务,并且用于一次执行许多任务。

任务注册和行动

让我们看一下构建脚本中的一个简单的“Hello World”任务:

tasks.register("hello") {

doLast {

println("Hello world!")

}

}tasks.register('hello') {

doLast {

println 'Hello world!'

}

}在示例中,构建脚本注册hello一个使用TaskContainer API调用的单个任务,并向其添加一个操作。

如果列出了项目中的任务,则该hello任务可供 Gradle 使用:

$ ./gradlew app:tasks --all

> Task :app:tasks

------------------------------------------------------------

Tasks runnable from project ':app'

------------------------------------------------------------

Other tasks

-----------

compileJava - Compiles main Java source.

compileTestJava - Compiles test Java source.

hello

processResources - Processes main resources.

processTestResources - Processes test resources.

startScripts - Creates OS-specific scripts to run the project as a JVM application.您可以使用以下命令在构建脚本中执行任务./gradlew hello:

$ ./gradlew hello Hello world!

当 Gradle 执行hello任务时,它会执行提供的操作。在这种情况下,操作只是一个包含一些代码的块:println("Hello world!")。

任务组和描述

hello上一节中的任务可以通过描述进行详细说明,并通过以下更新分配给一个组:

tasks.register("hello") {

group = "Custom"

description = "A lovely greeting task."

doLast {

println("Hello world!")

}

}将任务分配给组后,它将按以下方式列出./gradlew tasks:

$ ./gradlew tasks

> Task :tasks

Custom tasks

------------------

hello - A lovely greeting task.要查看有关任务的信息,请使用以下help --task <task-name>命令:

$./gradlew help --task hello

> Task :help

Detailed task information for hello

Path

:app:hello

Type

Task (org.gradle.api.Task)

Options

--rerun Causes the task to be re-run even if up-to-date.

Description

A lovely greeting task.

Group

Custom正如我们所看到的,该hello任务属于该custom组。

任务依赖关系

您可以声明依赖于其他任务的任务:

tasks.register("hello") {

doLast {

println("Hello world!")

}

}

tasks.register("intro") {

dependsOn("hello")

doLast {

println("I'm Gradle")

}

}tasks.register('hello') {

doLast {

println 'Hello world!'

}

}

tasks.register('intro') {

dependsOn tasks.hello

doLast {

println "I'm Gradle"

}

}$ gradle -q intro Hello world! I'm Gradle

taskXto的依赖taskY可以在taskY定义之前声明:

tasks.register("taskX") {

dependsOn("taskY")

doLast {

println("taskX")

}

}

tasks.register("taskY") {

doLast {

println("taskY")

}

}tasks.register('taskX') {

dependsOn 'taskY'

doLast {

println 'taskX'

}

}

tasks.register('taskY') {

doLast {

println 'taskY'

}

}$ gradle -q taskX taskY taskX

hello上一个示例中的任务已更新以包含依赖项:

tasks.register("hello") {

group = "Custom"

description = "A lovely greeting task."

doLast {

println("Hello world!")

}

dependsOn(tasks.assemble)

}现在任务hello依赖于assemble任务,这意味着 Gradle 必须先assemble执行任务才能执行任务:hello

$ ./gradlew :app:hello

> Task :app:compileJava UP-TO-DATE

> Task :app:processResources NO-SOURCE

> Task :app:classes UP-TO-DATE

> Task :app:jar UP-TO-DATE

> Task :app:startScripts UP-TO-DATE

> Task :app:distTar UP-TO-DATE

> Task :app:distZip UP-TO-DATE

> Task :app:assemble UP-TO-DATE

> Task :app:hello

Hello world!任务配置

注册后,可以通过TaskProvider API访问任务以进行进一步配置。

例如,您可以使用它在运行时动态向任务添加依赖项:

repeat(4) { counter ->

tasks.register("task$counter") {

doLast {

println("I'm task number $counter")

}

}

}

tasks.named("task0") { dependsOn("task2", "task3") }4.times { counter ->

tasks.register("task$counter") {

doLast {

println "I'm task number $counter"

}

}

}

tasks.named('task0') { dependsOn('task2', 'task3') }$ gradle -q task0 I'm task number 2 I'm task number 3 I'm task number 0

或者您可以向现有任务添加行为:

tasks.register("hello") {

doLast {

println("Hello Earth")

}

}

tasks.named("hello") {

doFirst {

println("Hello Venus")

}

}

tasks.named("hello") {

doLast {

println("Hello Mars")

}

}

tasks.named("hello") {

doLast {

println("Hello Jupiter")

}

}tasks.register('hello') {

doLast {

println 'Hello Earth'

}

}

tasks.named('hello') {

doFirst {

println 'Hello Venus'

}

}

tasks.named('hello') {

doLast {

println 'Hello Mars'

}

}

tasks.named('hello') {

doLast {

println 'Hello Jupiter'

}

}$ gradle -q hello Hello Venus Hello Earth Hello Mars Hello Jupiter

|

提示

|

调用doFirst和doLast可以多次执行。他们将操作添加到任务操作列表的开头或结尾。任务执行时,会按顺序执行动作列表中的动作。

|

named以下是用于配置插件添加的任务的方法示例:

tasks.named("dokkaHtml") {

outputDirectory.set(buildDir.resolve("dokka"))

}任务类型

Gradle 任务是Task.

在构建脚本中,HelloTask该类是通过扩展创建的DefaultTask:

// Extend the DefaultTask class to create a HelloTask class

abstract class HelloTask : DefaultTask() {

@TaskAction

fun hello() {

println("hello from HelloTask")

}

}

// Register the hello Task with type HelloTask

tasks.register<HelloTask>("hello") {

group = "Custom tasks"

description = "A lovely greeting task."

}该hello任务已注册为type HelloTask。

执行我们的新hello任务:

$ ./gradlew hello

> Task :app:hello

hello from HelloTask现在hello任务是 typeHelloTask而不是 type Task。

Gradlehelp任务揭示了变化:

$ ./gradlew help --task hello

> Task :help

Detailed task information for hello

Path

:app:hello

Type

HelloTask (Build_gradle$HelloTask)

Options

--rerun Causes the task to be re-run even if up-to-date.

Description

A lovely greeting task.

Group

Custom tasks写作任务

Gradle 任务是通过扩展DefaultTask.

但是,该泛型DefaultTask没有为 Gradle 提供任何操作。如果用户想要扩展 Gradle 及其构建脚本的功能,他们必须使用内置任务或创建自定义任务:

-

内置任务- Gradle 提供内置实用任务,例如

Copy、Jar、Zip、Delete等... -

自定义任务- Gradle 允许用户子类化

DefaultTask以创建自己的任务类型。

创建任务

创建自定义任务最简单、最快捷的方法是在构建脚本中:

要创建任务,请从该类继承DefaultTask并实现@TaskAction处理程序:

abstract class CreateFileTask : DefaultTask() {

@TaskAction

fun action() {

val file = File("myfile.txt")

file.createNewFile()

file.writeText("HELLO FROM MY TASK")

}

}它CreateFileTask实现了一组简单的操作。首先,在主项目中创建一个名为“myfile.txt”的文件。然后,一些文本被写入该文件。

注册任务

使用该方法在构建脚本中注册任务TaskContainer.register(),然后可以在构建逻辑中使用它。

abstract class CreateFileTask : DefaultTask() {

@TaskAction

fun action() {

val file = File("myfile.txt")

file.createNewFile()

file.writeText("HELLO FROM MY TASK")

}

}

tasks.register<CreateFileTask>("createFileTask")任务组和描述

设置任务的组和描述属性可以帮助用户了解如何使用您的任务:

abstract class CreateFileTask : DefaultTask() {

@TaskAction

fun action() {

val file = File("myfile.txt")

file.createNewFile()

file.writeText("HELLO FROM MY TASK")

}

}

tasks.register<CreateFileTask>("createFileTask", ) {

group = "custom"

description = "Create myfile.txt in the current directory"

}将任务添加到组后,在列出任务时即可看到该任务。

任务输入和输出

为了让任务做有用的工作,它通常需要一些输入。任务通常会产生输出。

abstract class CreateFileTask : DefaultTask() {

@Input

val fileText = "HELLO FROM MY TASK"

@Input

val fileName = "myfile.txt"

@OutputFile

val myFile: File = File(fileName)

@TaskAction

fun action() {

myFile.createNewFile()

myFile.writeText(fileText)

}

}

tasks.register<CreateFileTask>("createFileTask") {

group = "custom"

description = "Create myfile.txt in the current directory"

}配置任务

使用该方法可以选择在构建脚本中配置任务TaskCollection.named()。

该类CreateFileTask已更新,以便文件中的文本是可配置的:

abstract class CreateFileTask : DefaultTask() {

@get:Input

abstract val fileText: Property<String>

@Input

val fileName = "myfile.txt"

@OutputFile

val myFile: File = File(fileName)

@TaskAction

fun action() {

myFile.createNewFile()

myFile.writeText(fileText.get())

}

}

tasks.register<CreateFileTask>("createFileTask") {

group = "custom"

description = "Create myfile.txt in the current directory"

fileText.convention("HELLO FROM THE CREATE FILE TASK METHOD") // Set convention

}

tasks.named<CreateFileTask>("createFileTask") {

fileText.set("HELLO FROM THE NAMED METHOD") // Override with custom message

}在该named()方法中,我们找到createFileTask任务并设置将写入文件的文本。

任务执行时:

$ ./gradlew createFileTask

> Configure project :app

> Task :app:createFileTask

BUILD SUCCESSFUL in 5s

2 actionable tasks: 1 executed, 1 up-to-datemyfile.txt在项目根文件夹中创建一个名为的文本文件:

HELLO FROM THE NAMED METHOD请参阅“开发 Gradle 任务”一章以了解更多信息。

下一步: 了解如何使用插件>>

使用插件

Gradle 的大部分功能都是通过插件提供的,包括随 Gradle 分发的核心插件、第三方插件以及构建中定义的脚本插件。

插件引入新任务(例如,JavaCompile)、域对象(例如,SourceSet)、约定(例如,将 Java 源定位于src/main/java),并扩展核心或其他插件对象。

Gradle 中的插件对于自动化常见构建任务、与外部工具或服务集成以及定制构建过程以满足特定项目需求至关重要。它们还充当组织构建逻辑的主要机制。

插件的好处

在构建脚本中编写许多任务并复制配置块可能会变得混乱。与直接向构建脚本添加逻辑相比,插件具有以下几个优点:

-

促进可重用性:减少跨项目重复类似逻辑的需要。

-

增强模块化:允许更加模块化和有组织的构建脚本。

-

封装逻辑:保持命令式逻辑分离,从而实现更具声明性的构建脚本。

插件分发

您可以利用 Gradle 和 Gradle 社区的插件,也可以创建自己的插件。

插件可以通过三种方式使用:

-

核心插件- Gradle 开发并维护一组核心插件。

-

社区插件- 在远程存储库(例如 Maven 或Gradle 插件门户)中共享的 Gradle 插件。

-

本地插件- Gradle 使用户能够使用API创建自定义插件。

插件类型

插件可以实现为二进制插件、预编译脚本插件或脚本插件:

- 二进制插件

-

二进制插件是通常用 Java 或 Kotlin DSL 编写的编译插件,打包为 JAR 文件。它们被应用到使用块的项目中

plugins {}。与脚本插件或预编译脚本插件相比,它们提供更好的性能和可维护性。 - 预编译脚本插件

-

预编译脚本插件是 Groovy DSL 或 Kotlin DSL 脚本,它们被编译并作为打包在库中的 Java 类文件分发。它们被应用到使用块的项目中

plugins {}。它们提供了一种跨项目重用复杂逻辑的方法,并允许更好地组织构建逻辑。 - 脚本插件

-

脚本插件是 Groovy DSL 或 Kotlin DSL 脚本,它们使用语法直接应用于 Gradle 构建脚本

apply from:。它们在构建脚本中内联应用,以添加功能或自定义构建过程。它们使用起来很简单。

插件通常作为脚本插件启动(因为它们很容易编写)。然后,随着代码变得更有价值,它会被迁移到可以在多个项目或组织之间轻松测试和共享的二进制插件。

使用插件

要使用插件中封装的构建逻辑,Gradle 需要执行两个步骤。首先,它需要解析插件,然后需要将插件应用到目标,通常是Project.

-

解析插件意味着找到包含给定插件的 JAR 的正确版本并将其添加到脚本类路径中。一旦插件被解析,它的 API 就可以在构建脚本中使用。脚本插件是自我解析的,因为它们是从应用它们时提供的特定文件路径或 URL 解析的。作为 Gradle 发行版的一部分提供的核心二进制插件会自动解析。

-

应用插件意味着在项目上执行插件的Plugin.apply(T) 。

建议使用插件DSL一步解决并应用插件。

解决插件问题

Gradle 提供了核心插件(例如,JavaPlugin、GroovyPlugin、MavenPublishPlugin等)作为其分发的一部分,这意味着它们会自动解析。

核心插件使用插件名称应用在构建脚本中:

plugins {

id «plugin name»

}例如:

plugins {

id("java")

}非核心插件必须先解析后才能应用。非核心插件由构建文件中的唯一 ID 和版本来标识:

plugins {

id «plugin id» version «plugin version»

}并且必须在设置文件中指定插件的位置:

pluginManagement {

repositories {

gradlePluginPortal()

}

maven {

url 'https://maven.example.com/plugins'

}

}解决和应用插件还有其他注意事项:

| # | 到 | 使用 | 例如: |

|---|---|---|---|

将核心、社区或本地插件应用到特定项目。 |

|

||

将通用核心、社区或本地插件应用到多个子项目。 |

|

||

应用构建脚本本身所需的核心、社区或本地插件。 |

|

||

应用本地脚本插件。 |

|

plugins{}1. 使用块应用插件

插件 DSL 提供了一种简洁便捷的方式来声明插件依赖项。

插件块配置一个实例PluginDependenciesSpec:

plugins {

application // by name

java // by name

id("java") // by id - recommended

id("org.jetbrains.kotlin.jvm") version "1.9.0" // by id - recommended

}核心 Gradle 插件的独特之处在于它们提供短名称,例如java核心JavaPlugin。

要应用核心插件,可以使用短名称:

plugins {

java

}plugins {

id 'java'

}所有其他二进制插件必须使用插件 ID 的完全限定形式(例如com.github.foo.bar)。

要从Gradle 插件门户应用社区插件,必须使用完全限定的插件 id (全局唯一标识符):

plugins {

id("com.jfrog.bintray") version "1.8.5"

}plugins {

id 'com.jfrog.bintray' version '1.8.5'

}PluginDependenciesSpec有关使用插件 DSL 的更多信息,请参阅 参考资料。

插件 DSL 的限制

插件 DSL 为用户提供了方便的语法,并且让 Gradle 能够快速确定使用哪些插件。这使得 Gradle 能够:

-

优化插件类的加载和复用。

-

为编辑者提供有关构建脚本中潜在属性和值的详细信息。

然而,DSL 要求插件是静态定义的。

plugins {}区块机制和“传统”方法机制之间存在一些关键的区别apply()。还有一些限制和可能的限制。

约束语法

该plugins {}块不支持任意代码。

它被限制为幂等(每次产生相同的结果)和无副作用(Gradle 可以随时安全执行)。

形式为:

plugins {

id(«plugin id») // (1)

id(«plugin id») version «plugin version» // (2)

}-

for core Gradle plugins or plugins already available to the build script

-

for binary Gradle plugins that need to be resolved

plugins {

id «plugin id» // (1)

id «plugin id» version «plugin version» // (2)

}-

for core Gradle plugins or plugins already available to the build script

-

for binary Gradle plugins that need to be resolved

其中«plugin id»和«plugin version»是一个字符串。

其中«plugin id»和«plugin version»必须是常量、文字字符串。

该plugins{}块还必须是构建脚本中的顶级语句。它不能嵌套在另一个构造中(例如,if 语句或for 循环)。

仅在构建脚本和设置文件中

该块只能在项目的构建脚本和文件plugins{}中使用。它必须出现在任何其他块之前。它不能在脚本插件或初始化脚本中使用。build.gradle(.kts)settings.gradle(.kts)

将插件应用到所有子项目

假设您有一个多项目构建,您可能希望将插件应用于构建中的部分或全部子项目,但不应用于项目root。

虽然该块的默认行为plugins{}是立即resolve 使用 apply插件,但您可以使用apply false语法告诉 Gradle 不要将插件应用到当前项目。然后,plugins{}在子项目的构建脚本中使用没有版本的块:

include("hello-a")

include("hello-b")

include("goodbye-c")plugins {

id("com.example.hello") version "1.0.0" apply false

id("com.example.goodbye") version "1.0.0" apply false

}plugins {

id("com.example.hello")

}plugins {

id("com.example.hello")

}plugins {

id("com.example.goodbye")

}include 'hello-a'

include 'hello-b'

include 'goodbye-c'plugins {

id 'com.example.hello' version '1.0.0' apply false

id 'com.example.goodbye' version '1.0.0' apply false

}plugins {